Maîtriser l'entraînement des textes pour les grands modèles de langage (LLMs)

23 nov. 2023

Dans le monde dynamique de l'intelligence artificielle, Les grands modèles de langage (LLM) se tiennent à l'avant-garde, annonçant une nouvelle ère d'innovation et de possibilités. Ces modèles, renommés pour leur capacité à comprendre, générer et interpréter le langage humain, ont redéfini notre interaction avec la technologie. De l'assistance à la clientèle automatisée à l'analyse de données sophistiquée, les LLM transforment le paysage des applications d'IA.

Alors que nous plongeons dans les complexités de l'entraînement de ces LLM basés sur du texte, nous visons à équiper les chercheurs en IA, les chefs d'équipe et les passionnés avec des perspectives et des conseils pratiques. C'est un voyage à travers le labyrinthe de l'IA, où chaque tournant apporte de nouveaux défis et opportunités.

Architectures de modèles LLM

Choisir la bonne architecture de modèle est une étape fondamentale dans l'entraînement d'un LLM. Cette décision impacte tout, de la performance à l'évolutivité. Des architectures populaires comme Transformer, GPT et BERT apportent chacune des forces uniques.

L'architecture Transformer, rendue célèbre par l'article "Attention Is All You Need", est devenue un élément essentiel du traitement du langage naturel. Elle est connue pour son mécanisme d'attention, qui améliore la compréhension du contexte par le modèle en se concentrant sur différentes parties des données d'entrée.

Les modèles GPT, incarnés par le GPT-3 d'OpenAI, représentent une immense montée en échelle de l'architecture Transformer. Ils ont été entraînés sur d'énormes quantités de texte, leur permettant de générer un texte cohérent et contextuellement pertinent. Cette polyvalence les rend adaptés à une gamme de tâches, de la création de contenu à la conversation, et même à la programmation.

D'autre part, le BERT de Google (Représentations d'encodeurs bidirectionnels à partir de Transformers) a introduit une nouvelle approche de la modélisation linguistique. L'entraînement bidirectionnel de BERT, comme détaillé dans son article fondamental, lui permet de comprendre le contexte des mots en considérant à la fois les mots qui le précèdent et ceux qui le suivent.

Chacune de ces architectures est adaptée à différentes tâches et exigences. Le bon choix dépend de facteurs tels que la complexité de la langue, la taille de l'ensemble de données d'entraînement et l'application spécifique du modèle.

Défis et solutions liés au pré-entraînement

Pré-entraîner un LLM est une entreprise gourmande en ressources qui pose plusieurs défis. Parmi ceux-ci, la sélection des bonnes données d'entraînement et la gestion des exigences computationnelles sont cruciales.

Un pré-entraînement efficace est essentiel pour établir les compétences linguistiques fondamentales des LLM. Cela implique un entraînement sur de grands corpus pour équiper les modèles des capacités nécessaires à la génération et à la compréhension du langage. Cependant, ce processus n'est pas sans obstacles.

Sélection des données : La qualité et la diversité des données d'entraînement sont cruciales pour façonner la performance d'un LLM. Les données doivent être représentatives des contextes que le modèle rencontrera. Cela signifie qu'il faut curator soigneusement des ensembles de données qui soient complets, divers et impartiaux. Pour en savoir plus sur l'importance de la diversité des ensembles de données, cette étude fournit des informations sur la manière dont différents types de données peuvent impacter l'entraînement d'un LLM.

Exigences computationnelles : La puissance de calcul nécessaire pour entraîner des LLM est substantielle. Cela nécessite souvent d'utiliser du matériel spécialisé, ce qui peut coûter cher et prendre du temps. Pour équilibrer efficacement la taille du modèle, le volume de données et les ressources computationnelles, comprendre différentes approches de l'optimisation du modèle peut s'avérer très bénéfique.

Pour ceux qui cherchent à approfondir leur compréhension des défis et solutions liés au pré-entraînement, explorer des ressources comme le blog de DeepMind sur la modélisation linguistique peut fournir des informations précieuses.

Les avantages des LLM personnalisés

Les LLM personnalisés peuvent fournir des résultats plus précis et pertinents pour des applications spécifiques. Par exemple, un modèle entraîné sur la littérature médicale et l'historique des patients serait plus efficace dans une application de santé. La clé pour construire de tels modèles sur mesure réside dans la création de données d'entraînement efficaces.

Pour des idées sur la personnalisation des LLM pour des besoins spécifiques, cette ressource offre un aperçu de l'ensemble de données C4, qui est instrumental dans l'entraînement de modèles polyvalents.

Créer des données d'entraînement efficaces

Les données d'entraînement sont le souffle de vie de votre LLM. C'est ce qui enseigne à votre modèle le monde dans lequel il opérera. La clé ici est la qualité et la diversité. Vous voulez des données qui soient propres, variées et aussi impartiales que possible.

Collecter des données provenant d'une variété de sources est crucial. Dans notre exemple médical, cela pourrait inclure des revues médicales, des forums de patients et des rapports d'essais cliniques. Nettoyer ces données aide votre LLM à apprendre plus efficacement. Une source de données éthique et le respect des lois sur la vie privée ne sont pas seulement de bonnes pratiques ; c'est essentiel. Explorez davantage sur les techniques de collecte et de nettoyage des données ici.

Naviguer dans les considérations éthiques et éviter le contenu nuisible

Garantir que nos LLM soient éthiquement sains et exempts de préjugés nuisibles est une responsabilité que nous ne pouvons pas négliger. Des audits réguliers de vos données d'entraînement pour détecter les préjugés et les stéréotypes sont essentiels. Impliquer des équipes diverses dans le processus de développement peut apporter différentes perspectives. Filtrer les discours de haine et la désinformation de vos données d'entraînement est critique. Plongez plus profondément dans les considérations éthiques en IA avec cet article du blog Google AI.

Téléchargez notre livre blanc complet sur l'entraînement des LLM

Si tout cela vous intrigue autant que moi, il y a encore plus à explorer. Nous avons compilé un livre blanc complet sur l'entraînement des LLM qui n'attend que d'être exploré. Il est rempli d'idées, de stratégies et d'une analyse approfondie de tout ce que nous avons discuté ici et plus encore.

Téléchargez le livre blanc

Exploiter l'expertise en étiquetage des données

Collaborer avec un professionnel comme SmartOne peut faire une grande différence en matière d'étiquetage des données. L'expertise de SmartOne garantit que vos données d'entraînement sont annotées avec précision, ce qui se traduit directement par l'efficacité et l'efficience de votre LLM. Découvrez-en plus sur la façon dont les services d'étiquetage des données de SmartOne peuvent dynamiser votre entraînement LLM. Contactez SmartOne pour vos besoins en étiquetage de données.

De la compréhension des architectures de modèles à l'art délicat de l'étiquetage des données, nous avons couvert beaucoup de choses dans notre voyage à travers le monde des grands modèles de langage. Le domaine de l'IA et des LLM évolue constamment, et rester informé est clé. Continuez à explorer, continuez à apprendre, et surtout, continuez à expérimenter. Les possibilités sont infinies, et l'avenir est incroyablement excitant.

J'ai hâte de voir quelles choses incroyables vous réaliserez avec vos nouvelles connaissances en entraînement LLM. Jusqu'à la prochaine fois, bon modélisation des données !

Articles récents

Sommet de l'IA générative 2024

Sommet de l'IA générative 2024

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : contrôle logistique IA

Étude de cas client : contrôle logistique IA

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Classification des produits

Étude de cas client : Classification des produits

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Essayage virtuel de vêtements

Étude de cas client : Essayage virtuel de vêtements

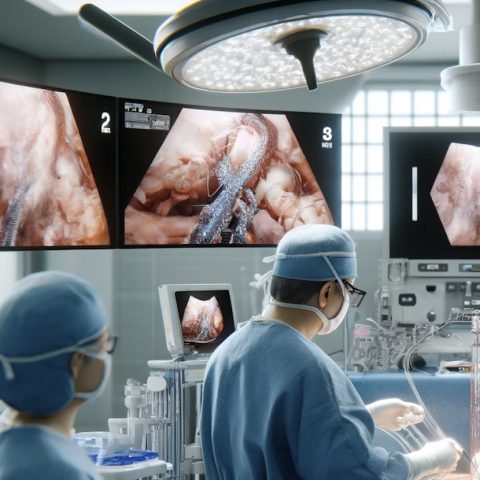

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données