Équipe Rouge IA : Garantir la sécurité et la sûreté des systèmes d'IA

7 mai 2024

Chez SmartOne.ai, nous sommes profondément conscients qu'à mesure que les technologies de l'IA évoluent et deviennent plus complexes, les défis et les risques associés à leur utilisation éthique et sécurisée le font aussi— IA éthique. Il s'agit d'un problème en cours et pressant dans la sécurité de l'IA de respecter les lignes directrices éthiques et de protéger contre les abus potentiels. Cette reconnaissance motive notre engagement envers des tests et une évaluation rigoureux des systèmes d'IA, où la pratique de l'IA Red Teaming joue un rôle indispensable. L'IA Red Teaming est essentielle pour identifier les vulnérabilités et garantir que les mises en œuvre de la sécurité de l'IA se font de manière responsable, protégeant les données des utilisateurs et maintenant la confiance du public.

Prenez une boisson et un en-cas alors que nous plongeons tête première dans le monde de l'IA Red Teaming et explorons son rôle critique dans la formation de l'avenir d'une intelligence artificielle sûre et éthique. Ensemble, nous découvrirons pourquoi maîtriser cette approche proactive est essentiel pour quiconque s'investit dans la prochaine génération de technologies d'IA.

Qu'est-ce que l'IA Red Teaming ?

L'IA Red Teaming n'est pas une mesure réactive, mais une approche proactive et complète face aux menaces cybernétiques et émergentes en évaluant la sécurité et la sûreté des systèmes d'IA. Elle implique de simuler des attaques adversariales potentielles pour identifier et atténuer les risques, garantissant la robustesse, la sécurité et la fiabilité des systèmes d'IA. Cela inclut un travail rigoureux par un groupe de professionnels de la sécurité experts en modélisation des menaces génératives d'IA pour anticiper les menaces potentielles et contrer une attaque ou des abus potentiels.

Une perspective historique du Red Teaming

Les origines fascinantes du Red Teaming peuvent être retracées aux pratiques militaires anciennes, où les dirigeants simulaient des attaques sur leurs forces pour identifier les vulnérabilités. Cette stratégie ancienne, imprégnée d'histoire, a évolué au fil des siècles, culminant en des formes plus structurées au 20ème siècle.

Au cours de la guerre froide, ce concept a été formalisé. Les États-Unis et leurs alliés s'engageaient régulièrement dans des jeux de guerre, où des équipes « rouges »—nommées pour leur association avec les drapeaux rouges de l'Union soviétique—adoptaient les tactiques et l'état d'esprit des forces soviétiques pour défier et améliorer leurs stratégies. Cette perspective historique souligne l'importance du Red Teaming, car il est devenu un outil vital pour la sécurité de l'IA.

À la fin du 20ème siècle, les méthodologies de Red Teaming ont transitionné du champ de bataille aux entreprises et aux gouvernements. Les organisations ont appliqué le Red Teaming pour remettre en question leurs plans et opérations, favorisant de meilleures décisions grâce à la pensée critique et à l'anticipation des tactiques adversariales. Cela s'est révélé particulièrement précieux dans des environnements complexes et à enjeux élevés où le coût de l'échec est élevé et où la nécessité de mesures de sécurité robustes est primordiale.

Aujourd'hui, le Red Teaming a trouvé un nouveau domaine vital dans l'intelligence artificielle. Dans la sécurité de l'IA, le Red Teaming se concentre principalement sur les tests de stress des modèles d'IA générative pour des dommages potentiels, allant des problèmes de sécurité et de sûreté aux biais sociaux. L'adaptation des pratiques militaires traditionnelles à la sécurité numérique reflète la flexibilité et la pertinence durable du Red Teaming en tant qu'outil d'amélioration et de résilience.

En comprenant les racines historiques incroyablement vitales et l'évolution du Red Teaming, nous pouvons mieux apprécier sa valeur dans les contextes contemporains, en particulier dans les technologies émergentes comme l'IA, où les enjeux continuent de croître parallèlement aux capacités de la technologie.

Le processus d'IA Red Teaming

L'IA Red Teaming a évolué en un processus hautement interactif et dynamique impliquant l'ingéniosité humaine et des systèmes d'IA sophistiqués. Ensemble, ils collaborent pour créer des prompts adversariaux qui mettent au défi les modèles d'IA de manière inattendue. Ces prompts sont explicitement conçus pour tester les limites des systèmes d'IA et identifier les vulnérabilités que des acteurs malveillants pourraient exploiter.

Par exemple, dans le contexte des modèles de traitement du langage naturel (NLP), une équipe rouge pourrait générer des prompts textuels contenant des manipulations subtiles conçues pour tromper l'IA en générant du contenu inapproprié ou nuisible. Cela pourrait impliquer l'utilisation de questions suggestives, de langage ambigu, ou l'introduction de biais pour voir si l'IA amplifie involontairement ces biais dans ses réponses.

Dans la reconnaissance d'images et l'IA générative, les prompts adversariaux incluent des images visuellement altérées qui déroutent l'IA. Cela peut être aussi simple que de changer l'éclairage et les angles dans une image ou aussi complexe que d'incorporer des éléments visuellement bruyants que les humains peuvent facilement ignorer, mais qui perturbent profondément les algorithmes de perception de l'IA. Un exemple pourrait être de présenter une image d'un panneau stop partiellement obscurci ou dégradé avec des autocollants—tandis qu'un conducteur humain reconnaîtrait toujours le panneau, une IA pourrait ne pas le faire, entraînant des problèmes de sécurité potentiels dans les systèmes de véhicules autonomes.

Ces modèles « red team » sont souvent des systèmes d'IA sophistiqués formés pour penser comme des attaquants. Ils utilisent des techniques provenant du domaine émergent de l'apprentissage automatique adversarial, où les modèles sont formés pour produire des entrées que d'autres systèmes d'IA interpréteront mal. Cela peut inclure la génération de discours que les systèmes de commande vocale interprètent mal, ce qui peut conduire à des actions non autorisées dans vos charges de travail d'IA.

De plus, dans les applications de cybersécurité, l'IA Red Teaming peut impliquer la simulation d'attaques de phishing où des emails ou des messages sont élaborés par l'IA pour paraître incroyablement réalistes, testant ainsi les systèmes d'IA conçus pour détecter de telles menaces et la capacité des employés humains à les reconnaître.

Ces prompts diversifient considérablement l'étendue et la profondeur des tests de sécurité, garantissant que les systèmes d'IA sont robustes dans des conditions ordinaires et prêts à gérer des risques de sécurité imprévus liés à l'IA ou des scénarios extrêmes. Ce test continu et rigoureux est crucial pour maintenir la confiance dans les applications d'IA, en particulier celles utilisées dans des domaines critiques tels que la santé, la finance et le transport autonome.

IA Red Teaming pour l'amélioration continue

Une équipe diversifiée pour le Red Teaming n'est pas seulement une recommandation ; c'est une nécessité. Cette diversité ne concerne pas seulement les parcours académiques et professionnels variés, mais également l'incorporation de différentes perspectives, approches cognitives et techniques de résolution de problèmes. Cette inclusivité est cruciale pour identifier un large éventail de vulnérabilités potentielles avant que des menaces externes puissent les exploiter, favorisant la collaboration et la responsabilité partagée en matière de sécurité de l'IA.

Meilleures pratiques pour l'IA Red Teaming :

Composition d'équipe diversifiée : Assurez-vous que l'équipe Red ou l'équipe de sécurité comprend des membres issus de disciplines variées telles que la cybersécurité, la psychologie, l'ingénierie logicielle, l'éthique, l'intelligence robuste et des domaines spécifiques pertinents pour l'application de l'IA. Cette diversité mène à une prévention précoce des menaces et à des scénarios de test plus créatifs et complets, et aide à découvrir des risques subtils, moins évidents, garantissant ainsi une IA sécurisée.

Cycles de test réguliers et itératifs : Les systèmes d'IA et les algorithmes d'IA doivent être soumis à un Red Teaming à intervalles réguliers, surtout après des mises à jour ou des changements significatifs dans le système. Les tests continus aident à détecter de nouvelles vulnérabilités qui pourraient avoir été introduites et garantissent que la sécurité de l'IA et les mécanismes de défense sont toujours à jour.

Simuler des scénarios réels : Les tests adversariaux doivent être ancrés dans des scénarios réalistes que l'IA pourrait rencontrer dans son environnement opérationnel. Cela inclut la simulation d'attaques d'ingénierie sociale pour les systèmes d'IA interagissant avec des humains ou la création de perturbations physiquement plausibles pour les systèmes basés sur la vision.

Tirer parti des technologies d'IA émergentes axées sur la détection des menaces : Défi l'IA en utilisant les derniers outils d'IA disponibles et les techniques de renseignement sur les menaces dans l'apprentissage automatique adversarial. Cela inclut l'utilisation de réseaux antagonistes génératifs (GAN) pour créer des entrées qui testent la robustesse de l'IA face à des entrées qui tentent de la tromper.

Rapports transparents et boucles de rétroaction : Lorsqu'il s'agit de sécuriser l'IA, il est crucial de rapporter les résultats de manière transparente à tous les intervenants après chaque cycle de test. Cela devrait être accompagné d'un mécanisme de rétroaction structuré qui garantit que les apprentissages sont intégrés dans la prochaine itération du système d'IA.

Considérations éthiques : Prenez toujours en compte les implications morales des méthodes de Red Teaming et les impacts potentiels des vulnérabilités identifiées. Assurez-vous que les tests ne compromettent pas la vie privée ou la sécurité des utilisateurs et respectent les directives et réglementations éthiques pour mieux protéger les informations et données sensibles, garantissant ainsi toujours une IA responsable.

Investir dans le développement des compétences : Les compétences de l'équipe Red doivent être continuellement mises à jour et élargies pour suivre le rythme des nouvelles tactiques adversariales et des avancées en matière de sécurité de l'IA. La formation et le développement sont cruciaux pour maintenir un avantage dans la sécurité de l'IA.

Le Red Teaming n'est pas seulement une question de recherche de défauts, mais fait partie intégrante du processus de développement qui garantit que les systèmes d'IA et la sécurité de l'IA peuvent fonctionner en toute sécurité et efficacité face aux menaces actuelles et futures.

Red Teaming en tant que service

L'avenir de l'IA recèle d'immenses promesses mais présente également d'importants défis en matière de sécurité. Chez SmartOne.ai, nous nous engageons à ouvrir la voie en matière d'IA Red Teaming, garantissant que les mises en œuvre de l'IA sont robustes, éthiques et sécurisées. Choisir un fournisseur de Red Teaming en tant que service (RTaaS) comme SmartOne.AI offre l'avantage d'une expertise externe essentielle pour découvrir et atténuer les vulnérabilités cachées. En tant que fournisseur choisi, nous simulons des scénarios adversariaux réalistes et fournissons des informations critiques que les équipes internes pourraient négliger, garantissant ainsi une véritable sécurité de l'IA.

Notre combinaison unique d'expertise en IA et d'expérience en cybersécurité nous positionne idéalement pour relever les défis multiples de la sécurité de l'IA. De l'évaluation initiale à la protection continue, nos services d'analyse des risques sont conçus pour garantir que vos applications d'IA respectent les normes les plus élevées d'intégrité et de fiabilité. Nous testons et affinons vos modèles d'IA et donnons à votre équipe les connaissances et les outils nécessaires pour maintenir la sécurité de manière autonome—Faites confiance à SmartOne.ai pour être votre allié dans la navigation dans le paysage évolutif des menaces et des opportunités liées à l'IA.

Articles récents

Sommet de l'IA générative 2024

Sommet de l'IA générative 2024

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : contrôle logistique IA

Étude de cas client : contrôle logistique IA

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Classification des produits

Étude de cas client : Classification des produits

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Essayage virtuel de vêtements

Étude de cas client : Essayage virtuel de vêtements

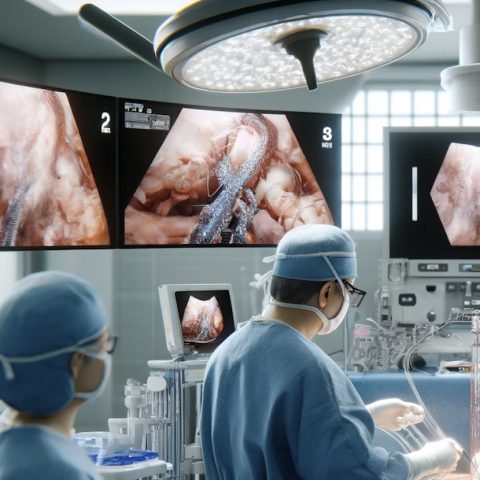

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données