Le guide incontournable pour les données d'entraînement en traitement du langage naturel

17 mai 2024

Les conversations quotidiennes contiennent un immense potentiel pour l'intelligence artificielle. En enseignant aux machines à comprendre et à répondre au langage naturel, des technologies telles que les chatbots sont considérablement améliorées, élargissant les capacités des outils technologiques à travers les industries. Notre guide utile vise à approfondir le Traitement Automatique du Langage Naturel (TALN) pour découvrir comment cette technologie fonctionne et pourquoi les données d'entraînement sont cruciales pour son déploiement réussi.

Alors, qu'est-ce que le Traitement Automatique du Langage Naturel (TALN) ?

En termes simples, le Traitement Automatique du Langage Naturel, ou TALN, est un domaine de l'intelligence artificielle qui se concentre sur l'interaction entre les ordinateurs et les humains à travers le langage naturel. L'objectif ultime du TALN est de lire, déchiffrer, comprendre et donnner un sens aux langues humaines de manière précieuse.

Les principaux composants du TALN :

Le TALN implique plusieurs étapes critiques pour fonctionner efficacement :

Décodage de l'entrée de l'utilisateur : La première étape consiste à interpréter ce que l'utilisateur dit dans une forme que la machine peut comprendre.

Prise de décision : Ensuite, la machine utilise des algorithmes pour décider de la réponse appropriée en fonction de l'entrée de l'utilisateur.

Réponse : Enfin, la machine génère une réponse que l'utilisateur peut comprendre.

De plus, ces étapes sont sous-tendues par trois actions principales : la compréhension, la prise de décision et la réponse. Par exemple, lorsque vous demandez à Alexa d'Amazon de commander du papier toilette, Alexa comprend la demande, décide de la meilleure façon de la remplir et confirme l'action en répondant. Consultez notre article populaire sur Comment annoter des données audio pour l'entraînement de modèles d'apprentissage automatique pour en savoir plus sur la façon dont Alexa et d'autres assistants AI peuvent être configurés.

Le rôle critique des données d'entraînement dans le TALN :

Les données d'entraînement sont le cœur de tout système de TALN. Ces données enseignent aux modèles AI comment comprendre et interagir avec le langage humain. Mais qu'est-ce qui constitue de bonnes données d'entraînement ?

De bonnes données d'entraînement doivent être :

Volumineuses : Plus il y a de données, mieux c'est, permettant au modèle d'apprendre à partir de nombreux scénarios.

Variées : La diversité des données aide le modèle à gérer différents dialectes, argots et contextes.

Précises : Des annotations de haute qualité sont cruciales pour enseigner correctement le modèle.

Les données d'entraînement peuvent provenir de diverses sources, comme notre 12 meilleures et gratuites ensembles de données de Traitement Automatique du Langage Naturel, du scraping web et des collectes de données propriétaires. Cependant, plus que des données brutes sont nécessaires. Elles doivent être nettoyées, étiquetées et organisées dans un format structuré à partir duquel les modèles peuvent apprendre.

Annotation des données : Le pilier d'un TALN efficace

L'annotation des données est un processus critique dans le développement des systèmes de TALN qui implique le marquage des données d'entraînement avec des étiquettes décrivant leur structure linguistique, leur intention, et leurs significations sémantiques. Cette tâche minutieuse est l'étape fondatrice pour enseigner aux modèles AI comment interpréter le langage humain avec précision. L'annotation des données pratiques englobe plusieurs niveaux :

Annotation d'entités : Ce type d'annotation se concentre sur l'identification et le marquage d'entités spécifiques au sein du texte, telles que des personnes, des lieux, des organisations et des dates. Par exemple, dans la phrase "George Washington est né en Virginie", "George Washington" serait étiqueté comme une personne et "Virginie" comme un lieu. Cela aide le système TALN à reconnaître et à catégoriser les entités correctement, ce qui est crucial pour des tâches telles que l'extraction d'informations et le liage d'entités.

Étiquetage de la partie du discours (POS) : Chaque mot dans une phrase est étiqueté en fonction de sa partie du discours, qu'il s'agisse d'un nom, d'un verbe, d'un adjectif, etc. Ce niveau d'annotation aide le modèle à comprendre les structures grammaticales et comment les mots dans une phrase se relient, améliorant la capacité du modèle à analyser le texte et à comprendre la syntaxe.

Annotation de dépendance syntaxique : Cela implique le marquage des relations entre les mots qui forment la structure d'une phrase. Par exemple, dans la phrase "Le chat est assis sur le tapis", les annotations de dépendance indiqueraient que "est assis" est le verbe principal, avec "le chat" comme sujet et "sur le tapis" comme lieu. Comprendre ces dépendances est crucial pour que l'IA puisse saisir la structure et le sens de la phrase.

Annotation sémantique : Les annotations sémantiques consistent à marquer des mots ou des phrases avec leurs significations, ce qui aide l'IA à comprendre le contexte et les ambiguïtés dans l'utilisation du langage. Cela pourrait inclure le lien d'un mot à sa signification dans une base de connaissances ou l'annotation de la phrase pour refléter des significations implicites ou des émotions.

Annotation pragmatique : Au-delà de la signification littérale, les annotations pragmatiques tiennent compte du contexte du langage et de son impact prévu. Cela inclut le ton, la politesse et le style, critiques pour des applications telles que les systèmes de dialogue où la machine doit imiter des interactions humaines.

Chaque annotation contribue à une compréhension globale du texte, permettant aux modèles TALN d'effectuer des tâches complexes telles que la réponse à des questions, la traduction automatique, et l'analyse des sentiments de manière plus efficace. La précision et la profondeur de ces annotations influencent directement la performance des technologies TALN, rendant l'annotation des données une partie indispensable du processus de développement de l'IA.

L'impact de l'annotation des données sur la précision du modèle :

La précision de l'annotation des données impacte significativement la performance des modèles TALN. Des annotations de données précises sont cruciales car elles influencent la capacité du modèle à interpréter, apprendre et répondre au langage humain efficacement. Voici un aperçu plus approfondi de la façon dont l'annotation des données affecte la précision des modèles :

Amélioration de l'entraînement du modèle : Des données bien annotées fournissent des exemples clairs pour l'entraînement des modèles AI. Par exemple, dans l'analyse des sentiments, l'annotation détermine si une phrase est positive, négative ou neutre. Cet entraînement permet aux modèles d'apprendre les nuances des émotions humaines et de répondre de manière appropriée. Si un modèle est entraîné avec des données mal annotées, sa capacité à interpréter correctement les sentiments est compromise, entraînant des réponses inexactes et une mauvaise expérience utilisateur.

Consistance à travers des entrées variées : L'annotation des données doit être cohérente pour assurer que le modèle fonctionne de manière fiable à travers différents ensembles de données et scénarios réels. Ceci est particulièrement important dans des tâches telles que la traduction de langues ou la modération de contenu, où des annotations incohérentes peuvent entraîner des erreurs significatives dans la sortie. Par exemple, si le sentiment 'frustration' est parfois étiqueté en tant qu' 'colère', le modèle pourrait avoir du mal à distinguer ces émotions légèrement différentes, affectant ainsi la précision de l'interaction et de l'analyse.

Compréhension contextuelle et génération de réponses : Dans des systèmes de dialogue complexes, le contexte dans lequel un mot ou une phrase est utilisé peut changer considérablement sa signification. Par exemple, "Je vais bien" peut être simple ou sarcastique, selon le contexte et le ton. Des annotations précises qui incluent des indicateurs contextuels et tonaux aident les modèles à comprendre et à générer des réponses contextuellement appropriées. Cela est particulièrement critique dans les bots de service client et l'IA interactive, où répondre de manière appropriée à l'humeur et au contexte de l'utilisateur peut définir la qualité du service.

Adaptation aux retours des utilisateurs : Une annotation de données précise permet aux systèmes TALN de mieux s'adapter aux retours des utilisateurs. Par exemple, des annotations de haute qualité permettent des ajustements plus efficaces dans des scénarios d'apprentissage interactif où le modèle s'ajuste en fonction des interactions des utilisateurs. Ce processus itératif, connu sous le nom d'apprentissage actif, dépend fortement des annotations initiales pour guider correctement les algorithmes d'apprentissage.

Réduction des biais et amélioration de l'équité : Enfin, une annotation précise des données est essentielle pour réduire les biais dans les modèles TALN. Les données biaisées peuvent amener les systèmes AI à développer des compréhensions déformées de certaines phrases ou concepts, perpétuant des stéréotypes ou entraînant des résultats discriminatoires ; en veillant à ce que les annotations de données soient diversifiées et représentatives de diverses démographies, les modèles peuvent être formés pour être plus justes et objectifs.

L'impact global de l'annotation des données sur la précision du modèle ne peut pas être sous-estimé. Elle sous-tend la capacité du modèle à effectuer ses tâches prévues avec précision et efficacité, en faisant un pilier des applications TALN réussies.

TALN à travers différentes langues :

La technologie fondamentale derrière le Traitement Automatique du Langage Naturel reste constante à travers les langues. Pourtant, l'application de cette technologie doit être spécialement adaptée pour tenir compte des caractéristiques linguistiques uniques de chaque langue. Des langues comme le japonais, qui ne séparent pas les mots par des espaces, présentent des défis spécifiques qui nécessitent des adaptations avancées dans l'analyse du texte.

Défis de segmentation : Dans des langues telles que le japonais et le chinois, l'absence de frontières de mots claires nécessite des algorithmes de segmentation sophistiqués. Ces algorithmes sont conçus pour identifier avec précision où un mot se termine et un autre commence, un processus connu sous le nom de tokenization. Une tokenization efficace est critique car elle forme la base de toutes les tâches TALN subséquentes, telles que le parsing et l'étiquetage de la partie du discours.

Nuances contextuelles : Au-delà des différences structurelles, les nuances linguistiques affectent également la manière dont les technologies TALN sont appliquées. Par exemple, de nombreuses langues présentent des systèmes flexionnels étendus où la forme d'un mot change pour exprimer différentes catégories grammaticales telles que le temps, le cas, ou le genre. Avec son schéma flexionnel relativement simple, les systèmes développés pour l'anglais peuvent avoir du mal avec la complexité des langues comme le russe ou l'arabe, nécessitant des modifications pour gérer ces complexités.

Contextes culturels : Les différences culturelles affectent également de manière significative la manière dont le langage est utilisé et compris. Les idiomes, les colloquialismes et les références culturelles peuvent varier considérablement entre les langues et les régions. Les systèmes TALN doivent être formés avec des exemples culturellement pertinents pour s'assurer qu'ils comprennent et génèrent un langage approprié et contextuellement exact.

Diversité des scripts : Le script d'une langue peut également avoir un impact sur le traitement TALN. Les langues qui utilisent des scripts non latins, tels que l'arabe, l'hindi ou le coréen, nécessitent souvent des technologies spécialisées de reconnaissance optique de caractères (OCR) et de gestion des polices. Chaque script a son propre ensemble de caractères et des règles pour la formation et la combinaison des caractères, ajoutant une autre couche de complexité au traitement du texte.

Stratégies d'adaptation : Les chercheurs et développeurs en TALN emploient diverses stratégies pour surmonter ces défis. Celles-ci incluent le développement de modèles spécifiques à une langue et d'ensembles de données d'entraînement, l'utilisation de modèles de langue universels qui sont affinés pour des langues spécifiques, et l'incorporation de données d'entraînement multilingues qui aident les modèles à apprendre à transférer des connaissances d'une langue à une autre.

La prise en charge de ces défis peut rendre les technologies TALN plus précises et efficaces dans le traitement des langues, rendant les systèmes AI accessibles et utiles à un public mondial. Cette adaptabilité améliore non seulement la fonctionnalité des applications AI mais élargit également leur impact à travers différents paysages linguistiques et culturels.

Avancées dans la technologie TALN :

À mesure que les technologies TALN avancent, elles utilisent l'apprentissage profond pour analyser et traiter de grands volumes de données linguistiques. Cela permet aux systèmes TALN de comprendre le sens littéral des mots et d'apprécier les subtilités du contexte, du ton et de l'émotion - essentiels pour une communication efficace.

Les données d'entraînement sont au cœur du succès du TALN. À mesure que les technologies avancent, la demande de données d'entraînement de haute qualité, bien annotées, comme celles auxquelles nous, chez SmartOne AI, nous spécialisons, ne fera que croître. Plus nous pouvons équiper nos modèles d'IA avec de bonnes données d'entraînement, plus ils deviendront sophistiqués et précieux.

Que vous soyez un scientifique des données, un développeur, un responsable de projet/produit ou un passionné d'IA, comprendre le rôle critique des données d'entraînement dans le TALN peut vous aider à apprécier les complexités et les capacités des technologies AI modernes. Si vous avez des questions ou des réflexions sur le TALN, n'hésitez pas à nous contacter. Nous sommes toujours heureux de discuter avec ceux qui s'intéressent au domaine de l'IA.

Articles récents

Sommet de l'IA générative 2024

Sommet de l'IA générative 2024

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : contrôle logistique IA

Étude de cas client : contrôle logistique IA

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Classification des produits

Étude de cas client : Classification des produits

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Essayage virtuel de vêtements

Étude de cas client : Essayage virtuel de vêtements

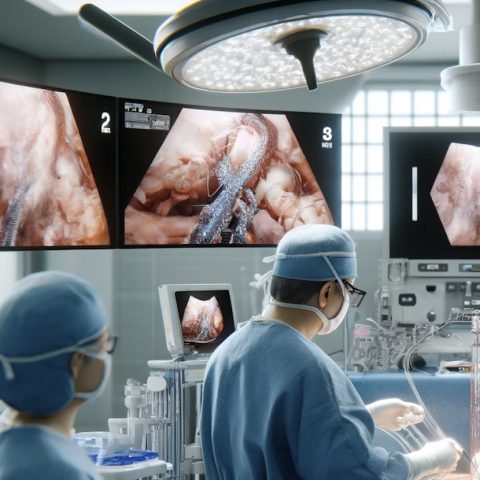

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données