Comment annoter des données audio pour l'entraînement de modèles d'apprentissage automatique

2 mai 2024

Alors, qu'est-ce que l'annotation des données audio ?

L'annotation des données audio est un processus par lequel la description ou les balises ajoutées aux fichiers audio permettent aux modèles d'apprentissage automatique de percevoir ou d'interpréter le son. Cela représente une étape importante dans le réglage des modèles d'IA pour les applications de reconnaissance vocale et de détection d'événements audio.

Le boum autour de l'annotation audio

Imaginez vivre dans un monde où la technologie peut discerner un murmure dans une tempête, reconnaître les différences nuancées entre des milliers de chants d'oiseaux, ou même prédire une défaillance de machines avant qu'elle ne se produise. Ce n'est pas une scène d'un roman futuriste ; c'est la réalité vers laquelle nous nous dirigeons avec le pouvoir de l'annotation des données audio par IA ou du marquage audio. Une base solide de données audio annotées est indispensable pour entraîner les modèles d'IA à reconnaître des voix, des genres musicaux ou des sons spécifiques dans des environnements bruyants.

Améliorer l'expérience utilisateur avec des services activés par la voix

Dans les services activés par la voix, l'annotation des données audio joue un rôle essentiel. Les assistants virtuels comme Apple Siri, Amazon Alexa ou Google Assistant sont devenus omniprésents dans notre vie quotidienne, nous aidant pour tout, depuis la mise en place d'alarmes jusqu'à la fourniture de mises à jour météorologiques en temps réel. Pour que ces systèmes d'IA comprennent et répondent avec précision à une myriade de commandes vocales, ils nécessitent une formation extensive sur des ensembles de données où la parole humaine est méticuleusement étiquetée, notant les variations d'accent, de tonalité et d'intonation.

Révolutionner les soins de santé par l'analyse audio : Le secteur de la santé peut tirer énormément parti des avancées en matière d'annotation audio. Les modèles d'IA sont désormais formés pour reconnaître les toux, les schémas respiratoires, et même les changements de voix subtils qui peuvent indiquer des problèmes de santé tels que des infections, des problèmes respiratoires ou des changements d'état de santé mentale. Les données audio annotées permettent à ces modèles de différencier une large gamme de sons à des fins de diagnostic, offrant potentiellement une détection précoce non invasive des conditions.

Avancer les mesures de sécurité avec la reconnaissance sonore : Les systèmes de sécurité exploitent de plus en plus l'annotation des données audio pour améliorer leurs capacités. Les modèles d'IA peuvent fournir des alertes en temps réel en annotant des données audio pour inclure des sons qui pourraient indiquer des intrusions, tels que du verre brisé, des alarmes ou une activité inattendue dans des zones restreintes. Cette application ne se limite pas à la sécurité physique ; elle s'étend à la cybersécurité, où des sons anormaux au sein des centres de données pourraient indiquer des défaillances matérielles ou un accès non autorisé.

Transformer la recherche environnementale par le monitoring bioacoustique : Le monitoring bioacoustique repose fortement sur des données audio annotées dans la recherche environnementale. Les scientifiques annotent les enregistrements d'habitats naturels pour étudier la biodiversité, surveiller les espèces menacées, et même détecter les activités d'exploitation illégale en reconnaissant les sons de tronçonneuse. Ces données aident à comprendre les dynamiques écologiques, évaluer la santé des habitats et guider les efforts de conservation.

Améliorer la sécurité publique avec des systèmes de détection d'urgence : Les systèmes d'IA sont également entraînés à reconnaître des signaux audio qui pourraient indiquer des urgences, tels que des accidents de voiture, des cris ou des coups de feu. Les données audio annotées permettent à ces systèmes de discerner ces sons critiques du bruit de fond, permettant des temps de réponse plus rapides pour les services d'urgence et potentiellement sauver des vies.

Types d'annotation audio

Améliorer notre compréhension des types d'annotations audio par IA élargit notre appréciation de la complexité impliquée dans l'annotation des données audio. Cela met en lumière le rôle critique de ces annotations dans l'entraînement des systèmes d'IA pour diverses tâches d'enregistrement audio.

Identification des locuteurs : L'identification des locuteurs implique de marquer les enregistrements audio pour indiquer quel individu parle à un moment donné. Ce processus est crucial pour des applications telles que les transcriptions automatisées de réunions, où les déclarations doivent être attribuées au bon participant, ou en matière de sécurité, où identifier la voix d'un locuteur peut authentifier son identité. Des algorithmes avancés analysent les caractéristiques vocales uniques aux individus, telles que la tonalité, le ton, et les schémas de discours, pour distinguer les locuteurs.

Reconnaissance des émotions : La reconnaissance des émotions vise à comprendre les émotions transmises par les tonalités de la voix, un domaine qui prend de l'ampleur dans les applications de service à la clientèle et de santé mentale. Les modèles d'IA peuvent détecter les émotions sous-jacentes telles que la joie, la tristesse, la colère ou le stress en analysant les variations de tonalité, de vitesse et d'intonation. Cette capacité permet aux centres d'appels d'améliorer l'interaction avec les clients en dirigeant les appels en fonction des signaux émotionnels ou contribue à surveiller la santé mentale des patients en évaluant leur état émotionnel dans le temps.

Transcription de la parole en texte : La transcription de la parole en texte convertit les mots parlés en texte écrit, la pierre angulaire de l'entraînement des modèles linguistiques. Ce service de transcription est vital pour créer des ensembles de données qui alimentent les applications de traitement du langage naturel (NLP), allant des assistants activés par la voix aux services de sous-titrage en temps réel. L'exactitude de ce processus est primordiale, car la qualité du texte transcrit affecte directement la capacité du modèle d'IA à comprendre et générer des réponses semblables à celles des humains. Si vous souhaitez tester par vous-même la transcription de la parole en texte, consultez cet article sur les meilleurs outils d'IA pour la prise de notes.

Détection d'événements sonores : La détection d'événements sonores implique de reconnaître et de catégoriser des sons ou événements spécifiques dans des flux audio. Ce type englobe diverses applications, de la surveillance environnementale (identification des sons de certaines espèces animales) à l'urbanisme (analyse des modèles de trafic par le son). Le défi réside ici dans l'identification précise des sons dans des environnements acoustiques complexes, nécessitant des modèles d'apprentissage automatique sophistiqués formés sur des annotations diverses et détaillées.

Deux excellents outils pour l'annotation des données audio

Audacity se distingue comme un éditeur d'annotation audio flexible et puissant, largement utilisé pour sa large gamme de fonctionnalités qui répondent à divers besoins en matière d'annotation audio. Les utilisateurs peuvent enregistrer de l'audio en direct, couper, copier, découper ou mixer des sons ensemble, et appliquer des effets aux enregistrements audio. Son accessibilité et ses outils complets d'édition de fichiers audio en font une ressource indispensable pour préparer des ensembles de données audio à annoter.

Sonic Visualiser est conçu pour la sonification visuelle et la mesure des fichiers audio, offrant une approche unique pour analyser et annoter des données audio. Il permet aux utilisateurs de visualiser et d'explorer le contenu spectral des fichiers audio, ce qui facilite l'identification et l'étiquetage des événements sonores spécifiques. Cet outil est très utile à des fins de recherche, où une analyse détaillée et une catégorisation des caractéristiques audio sont requises.

Préparer les données pour l'annotation audio

Préparer les données pour l'annotation audio implique une approche méticuleuse. Cela met l'accent sur la collecte et l'étiquetage d'enregistrements audio du fichier audio et sur la planification et l'exécution soigneuses de chaque étape afin d'assurer la qualité et la pertinence des données d'annotation audio pour les finalités de formation de l'IA.

Créer un ensemble de données audio : La fondation de tout projet d'annotation audio est de créer un ensemble diversifié d'enregistrements audio. Cette collection doit englober un large éventail d'environnements sonores, de locuteurs, de dialectes et d'événements sonores reflétant les scénarios du monde réel que le modèle d'IA rencontrera. Par exemple, si vous développez un assistant vocal, l'ensemble de données pourrait inclure des enregistrements de différents groupes d'âge, accents, et bruits de fond. L'objectif est de garantir la robustesse du modèle et sa capacité à performer avec précision à travers des entrées audio variées.

Définir les catégories d'annotation : Avant de commencer le processus d'annotation, il est crucial de déterminer les catégories que les annotateurs vont étiqueter. Ces catégories doivent s'aligner avec les objectifs du modèle d'IA et inclure l'identification des différents locuteurs par l'annotation de la parole, la reconnaissance d'émotions spécifiques véhiculées par la voix, ou la détection d'événements sonores distincts. Des définitions claires et des exemples pour chaque catégorie aident les annotateurs à comprendre les subtilités de leur étiquetage, garantissant la cohérence et l'exactitude des annotations.

Le processus d'annotation

Le processus d'annotation implique d'étiqueter activement des segments audio et de classer l'audio selon les catégories prédéfinies. Cette étape nécessite que les annotateurs écoutent les enregistrements audio et marquent les segments avec des balises pertinentes, ajoutant parfois des horodatages et un contexte supplémentaire pour aider à l'apprentissage du modèle d'IA. Utiliser un logiciel d'annotation qui permet une représentation visuelle des vagues sonores peut améliorer la précision, permettant aux annotateurs d'identifier et d'étiqueter plus efficacement des caractéristiques audio spécifiques.

La précision dans l'annotation audio est primordiale ; par conséquent, la vérification et les contrôles de qualité sont essentiels dans le processus de préparation. Cette phase implique de réviser les données annotées pour valider leur exactitude et leur cohérence. Employer une deuxième paire d'oreilles pour vérifier les annotations aide à identifier et rectifier les écarts. De plus, exploiter des outils de validation automatique peut signaler des erreurs potentielles pour les réviseurs humains, rationalisant le processus d'assurance qualité.

Enfin, transformer les données annotées en un format adapté aux ensembles de données de formation AI est essentiel. Ce processus implique de convertir les annotations en un format structuré, tel que JSON ou XML, qui respecte les exigences des modèles d'apprentissage automatique à former. Garantir que les données sont propres, bien organisées et compatibles avec les plates-formes de formation IA facilite un entraînement fluide et efficace du modèle d'annotation audio.

Aborder la complexité dans la détection des événements sonores

Distinguer entre une myriade d'événements sonores dans des enregistrements audio, en particulier dans des environnements riches de sons qui se chevauchent, présente un défi formidable. Imaginez essayer d'identifier le son d'une espèce d'oiseau spécifique dans une forêt tropicale animée ou de distinguer différents types de moteurs de véhicules dans la circulation urbaine ; la complexité est ahurissante. Cette complexité ne concerne pas seulement la variété des sons mais implique également la collecte de données robustes, des variations de volume, la distance par rapport à la source sonore, et les interférences dues aux bruits de fond.

La clé pour s'attaquer à cette complexité réside dans l'utilisation de modèles d'apprentissage machine avancés et d'un outil d'annotation audio de qualité capable d'une analyse audio approfondie. Des techniques telles que l'apprentissage profond et les réseaux neuronaux ont montré un succès remarquable dans l'extraction de caractéristiques à partir d'ensembles de données complexes, permettant aux modèles de reconnaître des motifs sonores cachés sous des couches de bruit. En formant ces modèles sur de vastes ensembles de données bien annotées, ils apprennent à identifier les différences subtiles qui distinguent un événement sonore d'un autre.

Les contrôles de qualité sont également primordiaux pour garantir la fiabilité des systèmes de détection d'événements sonores. Ce processus implique de vérifier l'exactitude des annotations sonores dans les ensembles de données de formation et de tester continuellement les performances du modèle dans des conditions variées. La mise en œuvre de mécanismes de contrôle de qualité robustes aide à affiner la capacité du modèle à gérer des environnements sonores complexes, minimiser les erreurs et améliorer la précision de la détection.

Enseigner à votre modèle AI à reconnaître des motifs sonores complexes

Éduquer les modèles d'IA à discerner des motifs sonores complexes nécessite une approche stratégique de la formation ; cela implique :

Créer des ensembles de données audio diversifiés : Réunir des ensembles de données représentant des environnements audio et des événements sonores. La diversité dans les données d'entraînement est cruciale pour développer la capacité d'un modèle à généraliser à partir de son entraînement et à performer avec précision dans des scénarios du monde réel.

Simuler des conditions du monde réel : Incorporer des simulations des complexités audio réelles, telles que des niveaux sonores variables, des échos, et des bruits de fond, dans le processus de formation. Cela aide le modèle à s'adapter à l'imprévisibilité des tâches de détection sonore en situation réelle.

Apprentissage progressif : Commencer par des sons plus simples et introduire progressivement des complexités, permettant à l'IA de capitaliser sur ses apprentissages de manière progressive. Cette approche par étapes aide à renforcer les capacités du modèle à chaque niveau avant de passer à des scénarios plus difficiles.

Mécanismes de rétroaction : Mettre en œuvre des mécanismes de rétroaction qui permettent au modèle d'apprendre de ses erreurs. En analysant des instances de mauvaise identification ou de détections manquées, le modèle peut ajuster ses paramètres pour de meilleures performances futures.

Potentiel des annotations de données audio par IA et évolution continue

Les applications potentielles pour l'annotation de données audio par IA sont aussi vastes que vitales. De la création d'interfaces utilisateur plus intuitives à la sauvegarde de notre santé et de notre environnement, le processus détaillé d'annotation des données audio est au cœur de ces avancées technologiques. À mesure que l'IA continue d'évoluer, la demande pour des ensembles de données audio annotées avec précision ne fera que croître, soulignant l'importance de cette tâche méticuleuse dans le façonnement d'un avenir où la technologie comprend non seulement les données mais le monde qui nous entoure à travers le son.

Comme nous l'avons montré, les services d'annotation de données révèlent leur rôle critique dans divers secteurs, soulignant leur importance dans le développement de systèmes d'IA plus réactifs qui sont mieux à l'écoute des subtilités du monde auditif. Pour ceux d'entre vous qui souhaitent approfondir vos connaissances, nous espérons que cet article aura élargi votre base de connaissances, et nous vous souhaitons... Bonne écoute audio par IA !

Articles récents

Sommet de l'IA générative 2024

Sommet de l'IA générative 2024

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : contrôle logistique IA

Étude de cas client : contrôle logistique IA

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Classification des produits

Étude de cas client : Classification des produits

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Essayage virtuel de vêtements

Étude de cas client : Essayage virtuel de vêtements

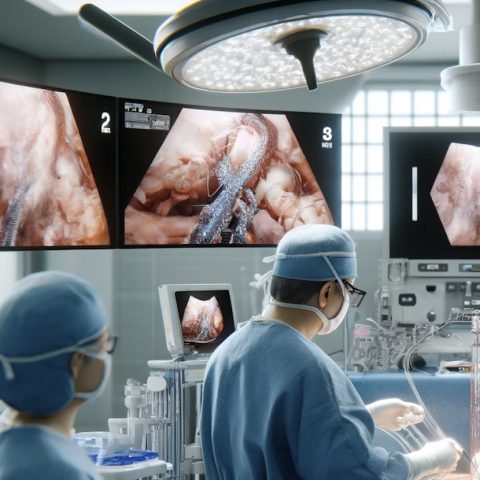

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données