Amélioration des grands modèles de langage avec l'étiquetage et la formation des données (Livre blanc)

21 déc. 2023

Table des Matières

VIII. Intégration de Données Synthétiques dans l'Entraînement des LLMs

XI. Application des LLMs dans les Applications Industrielles

I. L'Ascension des Grands Modèles Linguistiques (LLMs)

Ces dernières années, le domaine du traitement du langage naturel a connu une croissance phénoménale, marquée par l'émergence de grands modèles linguistiques révolutionnaires tels que GPT-3 (Transformateur Génératif Pré-entraîné 3) et BERT (Représentations de l'Encodeur Bidirectionnel à partir de Transformateurs). Ces technologies ont changé la façon dont les ordinateurs interprètent et génèrent le langage humain, ouvrant la voie à des avancées significatives dans divers domaines, y compris l'intelligence artificielle (IA), la traduction automatique et les assistants virtuels. Cela a entraîné leur adoption à grande échelle dans divers secteurs, allant de la santé et des finances à l entretenimiento et au service client, transformant les opérations commerciales et les interactions avec les clients (Devlin et al., 2019; Brown et al., 2020).

Malgré leurs capacités impressionnantes, les LLMs ne sont pas sans défis. Certaines limites continuent d'entraver leur potentiel, soulignant la nécessité de données étiquetées robustes et précises. Ce document examine le rôle crucial des données dans l'exploitation de toutes les capacités des LLMs, et comment SmartOne aborde ces défis à travers les meilleures pratiques en matière d'étiquetage et d'annotation des données.

II. Architectures Avancées des Modèles dans les LLMs

Alors que les LLMs continuent de révolutionner le domaine du traitement du langage naturel, les architectures de modèles sous-jacentes jouent un rôle déterminant dans leurs capacités et performances. Cette section se penche sur les architectures à la pointe de la technologie qui propulsent les avancées actuelles et futures des LLMs.

A. Évolution des Architectures de Modèles

L'évolution des architectures LLM a été marquée par des jalons significatifs. Les premiers modèles reposaient sur des réseaux neuronaux plus simples, mais l'avènement de l'apprentissage profond a apporté des structures plus sophistiquées. L'introduction des Réseaux Neuronaux Récurrents (RNNs) et des Réseaux à Mémoire à Long Court Terme (LSTM) a permis un meilleur traitement des données séquentielles, un aspect crucial du traitement du langage. Cependant, ces modèles avaient souvent du mal avec les dépendances à long terme et l'efficacité computationnelle.

La percée est venue avec le développement de l'architecture Transformer, introduite dans l'article « Attention Is All You Need » par Vaswani et al. (2017). Les Transformers ont abandonné les couches récurrentes au profit de mécanismes d'attention, permettant au modèle de traiter les données d'entrée en parallèle et de se concentrer sur différentes parties de la séquence d'entrée, améliorant ainsi l'efficacité et la compréhension du contexte.

B. Modèles Transformer : Le Cœur des LLMs Modernes

Les modèles Transformer sont devenus l'épine dorsale des LLMs modernes, incluant des exemples notables comme GPT et BERT. Ces modèles présentent plusieurs caractéristiques clés :

Mécanisme d'Auto-Attention : Cela permet au modèle de peser l'importance des différents mots dans une phrase, fournissant une compréhension dynamique du contexte.

Structure en Couches : Plusieurs couches d'attention et de réseaux à propagation avant permettent au modèle d'apprendre des motifs complexes et des relations dans les données.

Préformation et Affinement : Les modèles Transformer sont souvent préformés sur de vastes ensembles de données, puis affinés pour des tâches spécifiques, les rendant très polyvalents.

C. Au-delà des Transformers : Architectures Émergentes

Bien que les Transformers dominent actuellement le domaine, la recherche continue d'évoluer :

Transformers Efficaces : Des variantes comme le Reformer ou le Linformer visent à réduire la complexité computationnelle des modèles Transformer standard, leur permettant de traiter des séquences plus longues plus efficacement.

Modèles Hybrides : Combiner des aspects des Transformers avec d'autres architectures de réseaux neuronaux pour tirer parti des forces de chacune.

Réseaux de Neurones Graphiques (GNNs) : Pour les tâches impliquant la compréhension des relations et des structures, comme dans les graphes de connaissances, les GNNs sont explorés comme un complément ou une alternative aux modèles Transformer.

D. Défis et Directions Futures

Malgré leurs succès, les modèles Transformer sont confrontés à des défis tels que l'intensité computationnelle, en particulier lorsqu'il s'agit de traiter de grands ensembles de données. Il y a aussi un effort continu pour rendre ces modèles plus interprétables et comprendre leurs processus de prise de décision.

La recherche future se concentre sur la création de modèles plus efficaces, adaptables et transparents. Cela comprend l'exploration de nouvelles architectures capable de traiter des données diversifiées et multimodales, et des modèles qui peuvent apprendre plus efficacement avec moins de données – un mouvement vers une IA plus efficace en matière de données.

III. La Fondation : Données dans les LLMs

Au cœur du succès des LLMs se trouve leurs données d'entraînement. Ces modèles sont alimentés en vastes ensembles de données diversifiées comprenant du texte provenant de diverses sources telles qu'Internet, des livres et des articles. La qualité et les caractéristiques de ces données d'entraînement sont d'une importance capitale car elles influencent les performances du modèle, les considérations éthiques et les biais potentiels qui peuvent en résulter.

A. La Nécessité de Données de Qualité

L'essence de l'IA réside dans sa capacité à traiter d'énormes quantités de données, et les LLMs ne font pas exception. Ces modèles dépendent de vastes données textuelles pour apprendre et comprendre les subtilités de la langue humaine, y compris ses motifs, son contexte et ses nuances subtiles. La qualité de ces données est un déterminant clé des performances du modèle et de son efficacité dans des applications réelles (Vaswani et al., 2017). Des données mal étiquetées ou inexactes peuvent conduire à des conclusions incorrectes, des modèles biaisés et, en définitive, des systèmes d'IA peu fiables.

B. L'Influence de la Qualité des Données sur la Performance et la Fiabilité

La fiabilité et la performance des LLMs sont intrinsèquement liées à la qualité de leurs données d'entraînement. Des inexactitudes ou des incohérences dans les données peuvent entraîner des erreurs et des biais, compromettant la fiabilité du système d'IA (Bender et al., 2021). Garantir des ensembles de données de haute qualité et correctement étiquetées est donc une priorité absolue, car cela permet aux LLMs de générer un texte cohérent et contextuellement pertinent. S'attaquer aux préoccupations liées à la qualité des données est fondamental pour libérer le plein potentiel des LLMs dans diverses applications.

IV. Étiquetage des Données et Annotations

L'étiquetage et l'annotation des données sont des processus clés dans l'entraînement des LLMs. Cela implique d'assigner des étiquettes ou des annotations pertinentes à des données brutes, ce qui aide les modèles d'IA à comprendre le contexte, l'intention et la sémantique au sein des données textuelles. Ces annotations fournissent le contexte et la sémantique nécessaires aux modèles pour générer des réponses cohérentes et significatives (Brown et al., 2020).

A. Comprendre les Limitations des LLMs Actuels

Les LLMs actuels, malgré leurs avancées, présentent plusieurs limitations qui affectent leur performance globale. Celles-ci incluent des biais dans les réponses, un manque de compréhension contextuelle et la nécessité de données d'entraînement plus complètes. S'attaquer à ces limitations est crucial pour libérer tout le potentiel des LLMs à travers diverses applications, allant des chatbots au service client aux plateformes de génération de contenu (Bender et al., 2021).

B. Le Processus d'Entraînement des LLMs

Le processus d'entraînement des LLMs est une procédure en plusieurs étapes qui implique la collecte de données, le prétraitement des données, l'annotation et l'entraînement du modèle. Chaque étape joue un rôle critique pour garantir l'efficacité du modèle. Le processus commence par la collecte d'un ensemble de données diversifié et représentatif, suivi du nettoyage et du formatage des données pendant le prétraitement. Ensuite, l'annotation consiste à étiqueter les données pour enseigner au modèle la compréhension du langage et du contexte. Enfin, le modèle est entraîné à l'aide de techniques d'apprentissage profond pour reconnaître les motifs dans les données (Vaswani et al., 2017).

C. Meilleures Pratiques en Matière d'Étiquetage et d'Annotation des Données

Dans le domaine de l'étiquetage et de l'annotation des données, il est important de suivre les meilleures pratiques pour garantir des résultats de haute qualité. Cela inclut la mise en œuvre de mesures strictes de contrôle qualité, la validation régulière des données et l'équilibre entre l'annotation humaine et les méthodes automatisées. De plus, des plateformes d'annotation évolutives et des options d'externalisation peuvent être explorées pour gérer efficacement de grands ensembles de données (Brown et al., 2020).

V. Défis et Solutions en Étiquetage de Données

L'étiquetage des données, le processus d'identification et de marquage des données brutes pour les modèles d'IA, est un aspect critique mais souvent difficile de l'entraînement des LLMs. Cette section aborde les défis courants dans l'étiquetage des données et comment les solutions novatrices de SmartOne s'attaquent à ces problèmes, améliorant ainsi la précision et l'efficacité des LLMs.

A. Défi : Volume et Évolutivité

L'un des principaux défis de l'étiquetage des données est la gestion de l'immense volume de données nécessaires pour entraîner et affiner efficacement les Grands Modèles Linguistiques. Ces données doivent non seulement être étiquetées, mais aussi validées et potentiellement réétiquetées à mesure que les modèles évoluent, en particulier lors de l'adaptation à des méthodologies d'entraînement avancées.

Solution : Outils Automatisés et Plateformes Évolutives

Pour s'attaquer au volume significatif de données nécessaires à l'entraînement et à l'affinement des LLMs, SmartOne adopte une approche polyvalente. Nous tirons parti d'une combinaison de nos propres outils automatisés, de ressources tierces et d'outils exclusifs accessibles grâce à nos partenariats technologiques. Cette approche flexible nous permet de gérer efficacement des projets d'étiquetage de données à grande échelle, en particulier ceux impliquant des méthodes de fine-tuning sophistiquées telles que l'Apprentissage par Renforcement à partir des Retours Humains (RLHF) et le Finetuning Supervisé (SFT), ainsi que l'entraînement basé sur des invites. Ces méthodologies sont essentielles pour améliorer la performance et l'applicabilité des LLMs dans divers scénarios, nécessitant des processus d'étiquetage et de validation des données minutieux que nos plateformes sont bien équipées pour gérer.

B. Défi : Maintenir une Haute Qualité et Précision

La qualité est primordiale dans l'étiquetage des données, car les inexactitudes peuvent entraîner des biais et des erreurs dans le modèle d'IA final.

Solution : Contrôle Qualité Rigoureux et Annotateurs Experts

SmartOne met en œuvre des mesures strictes de contrôle qualité à chaque étape du processus d'étiquetage. Des annotateurs experts sont employés pour superviser l'exactitude des données étiquetées, et des audits réguliers sont effectués pour assurer les normes de qualité les plus élevées. Les programmes de formation pour les annotateurs sont continuellement mis à jour pour suivre l'évolution des exigences en matière de données.

C. Défi : Diversité et Représentation des Données

Assurer des ensembles de données diversifiés et représentatifs est crucial pour prévenir les biais dans les modèles d'IA. Cependant, atteindre cette diversité dans la collecte et l'étiquetage des données peut être complexe.

Solution : Approvisionnement Équitable en Données et Pratiques d'Étiquetage Inclusives

SmartOne s'engage à contester et à améliorer la diversité et l'inclusivité dans nos projets. Notre équipe diversifiée d'annotateurs, principalement d'Afrique, apporte une pluralité de perspectives au processus d'étiquetage des données. Cette diversité n'est pas seulement géographique, mais englobe également divers contextes culturels et linguistiques, garantissant que les données que nous étiquetons sont inclusives et culturellement pertinentes. Cette approche est cruciale pour développer des LLMs qui sont équitables, impartiaux et véritablement globaux dans leur compréhension.

D. Défi : Exigences de Données Complexes et Spécialisées

Les LLMs dans des domaines spécialisés tels que la santé ou la finance nécessitent des données qui ne sont pas seulement étiquetées avec précision, mais qui respectent également les normes et réglementations spécifiques de l'industrie.

Solution : Expertise Spécialisée et Conformité

SmartOne collabore avec des experts du domaine pour comprendre les nuances des domaines spécialisés. Ces experts orientent le processus d'étiquetage pour s'assurer que les données répondent à la fois aux exigences techniques des LLMs et aux normes réglementaires de l'industrie. Des équipes de conformité sont également en place pour examiner et mettre à jour régulièrement les pratiques de traitement des données.

E. Défi : Suivre l'Évolution des Modèles d'IA

À mesure que les modèles d'IA évoluent, notamment dans le domaine des méthodes de fine-tuning comme RLHF, SFT et l'entraînement basé sur des invites, les exigences en matière d'étiquetage des données changent également. S'adapter à ces besoins évolutifs est un défi constant.

Solution : Méthodologies Agiles et Apprentissage Continu

SmartOne utilise des méthodologies agiles, permettant une adaptation rapide aux dernières techniques de fine-tuning dans l'entraînement des LLMs. Nos programmes d'apprentissage continu pour les annotateurs sont régulièrement mis à jour pour englober de nouveaux développements en RLHF, SFT et l'entraînement basé sur des invites, assurant ainsi que nos processus d'étiquetage des données restent alignés avec les avancées de pointe en matière d'IA et de LLMs.

VI. Apprentissage Fédéré pour des LLMs Préservant la Vie Privée

Les LLMs sont intégrés dans diverses applications, leur entraînement nécessitant souvent d'énormes ensembles de données, soulevant d'importantes préoccupations en matière de vie privée. Les méthodes d'entraînement centralisées traditionnelles nécessitent de regrouper des données diverses dans un serveur central, ce qui peut poser des risques potentiels si des informations sensibles sont impliquées. S'attaquer à ces préoccupations est essentiel pour favoriser la confiance des utilisateurs et garantir un développement de l'IA responsable.

A. Préoccupations en matière de Vie Privée dans l'Entraînement des LLMs

L'Apprentissage Fédéré émerge comme une solution innovante aux défis de confidentialité inhérents à l'entraînement des LLMs. Cette approche collaborative permet d'entraîner des modèles sur des appareils ou serveurs décentralisés sans échanger de données brutes. Au lieu de cela, seules les mises à jour du modèle sont communiquées, préservant ainsi la vie privée des entrées des utilisateurs individuels. Cette approche améliore non seulement la confidentialité, mais atténue également les risques associés à la centralisation d'informations sensibles.

B. Composants Clés de l'Apprentissage Fédéré

Serveurs d'Entraînement Décentralisés : Dans un cadre d'apprentissage fédéré, l'entraînement a lieu sur des serveurs ou des appareils locaux, éliminant ainsi la nécessité d'un serveur central pour héberger l'ensemble du jeu de données. Cette structure décentralisée minimise considérablement les chances de violation de données.

Agrégation Sécurisée du Modèle : Les mises à jour du modèle provenant de serveurs locaux sont agrégées de manière sécurisée pour créer un modèle global. Des techniques cryptographiques avancées garantissent que les mises à jour individuelles restent privées pendant ce processus d'agrégation.

Mesures de Vie Privée Différentielle : L'apprentissage fédéré intègre souvent la confidentialité différentielle, ajoutant du bruit aux mises à jour individuelles pour empêcher l'extraction d'informations spécifiques. Cette mesure de confidentialité statistique ajoute une couche supplémentaire de protection aux données sensibles.

C. Avantages de l'Apprentissage Fédéré pour les LLMs

Préservation de la Vie Privée : L'avantage primordial de l'apprentissage fédéré est la préservation de la vie privée des utilisateurs. Cette approche permet aux LLMs d'apprendre à partir d'une large gamme de données sans compromettre la confidentialité des contributions individuelles.

Réduction du Transfert de Données : Comme seules les mises à jour du modèle sont communiquées, la quantité de données transférées entre appareils ou serveurs est considérablement réduite par rapport à l'entraînement centralisé traditionnel. Cela est particulièrement bénéfique pour les utilisateurs ayant une bande passante limitée.

Entraînement sur Appareils Edge : L'apprentissage fédéré prend en charge l'entraînement de modèles sur des appareils edge, tels que les smartphones ou les appareils IoT. Cela permet à ces appareils d'apprendre localement et de contribuer au modèle global sans exposer des informations sensibles.

D. Défis et Directions Futures

Malgré son potentiel prometteur, l'apprentissage fédéré fait face à des défis tels que l'efficacité communicationnelle, la synchronisation des modèles et la robustesse face aux distributions de données non-IID (Non-Indépendamment et Identiquement Distribuées). Les directions futures comprennent l'optimisation des algorithmes fédérés, l'adressage des préoccupations de sécurité et la promotion de cadres standards pour l'interopérabilité.

L'apprentissage fédéré représente un paradigme novateur préservant la vie privée pour l'entraînement des Grands Modèles Linguistiques. En facilitant la collaboration sans compromettre les données sensibles, cette approche s'aligne sur les pratiques éthiques de l'IA et contribue au développement de modèles linguistiques responsables et dignes de confiance.

VII. Étiquetage de Données Multimodales

L'intégration de données multimodales – combinant texte, images, audio ou autres entrées sensorielles – est devenue de plus en plus vitale pour faire progresser les LLMs. L'apprentissage multimodal améliore la compréhension du contexte du modèle et fournit une base plus complète pour générer des réponses nuancées et contextuellement pertinentes (Vaswani et al., 2017).

A. Défis dans l'Étiquetage de Données Multimodales

Exploiter efficacement les données multimodales nécessite une étiquetage précis et diversifié. Cela pose des défis uniques en raison de la nature variée des entrées multimodales. Contrairement au texte, qui est intrinsèquement présent dans l'entraînement des LLMs, d'autres modalités nécessitent des processus d'annotation spécialisés. Les images peuvent exiger une reconnaissance d'objets, l'audio nécessite une transcription, et la vidéo nécessite une étiquetage au niveau des images. Réaliser un étiquetage précis et complet à travers ces modalités diverses est essentiel pour entraîner des LLMs multimodaux robustes.

B. Stratégies pour l'Étiquetage de Données Multimodales

Apprentissage par Transfert pour les Modalités : Tirer parti de modèles pré-entraînés pour des modalités individuelles, comme des classificateurs d'images ou des modèles de reconnaissance vocale, peut réduire considérablement l'effort d'étiquetage. Cette approche d'apprentissage par transfert permet au LLM de bénéficier d'ensembles de données étiquetées existants pour des modalités spécifiques (Pan & Yang, 2010).

Annotation par la foule et Annotation d'Experts : Combiner la puissance de l'annotation par la foule avec l'annotation d'experts garantit à la fois diversité et précision dans l'étiquetage de données multimodales. Les annotateurs de la foule peuvent gérer de grands volumes de données, tandis que les experts de domaine apportent des insights nuancés, particulièrement dans des domaines spécialisés (Howe, 2006).

Apprentissage Actif pour les Entrées Multimodales : La mise en œuvre de stratégies d'apprentissage actif pour les données multimodales implique de sélectionner itérativement des exemples qui sont difficiles pour le modèle. En se concentrant sur des instances où le modèle manifeste de l'incertitude, cette approche optimise le processus d'étiquetage, garantissant que les efforts sont dirigés là où ils sont les plus nécessaires (Settles, 2009).

C. Avantages de l'Apprentissage Multimodal pour les LLMs

Compréhension Contextuelle : Les données multimodales enrichissent la compréhension contextuelle des LLMs en considérant un spectre plus large d'informations. Cela mène à des réponses plus nuancées qui intègrent des informations provenant de diverses modalités.

Applications du Monde Réel : L'application de l'apprentissage multimodal s'étend à des scénarios du monde réel tels que la génération de légendes d'images, les assistants activés par la voix et la génération de contenu. Les LLMs formés sur des données multimodales excellent dans des tâches nécessitant une compréhension holistique des entrées diverses.

VIII. Intégration de Données Synthétiques dans l'Entraînement des LLMs

Dans les avancées récentes dans le domaine des LLMs, l'émergence de données synthétiques se démarque comme une innovation significative. Les données synthétiques, des données générées artificiellement qui imitent les données du monde réel, offrent un nouveau terrain d'entraînement pour les LLMs. Elles répondent à des défis tels que la rareté des données, les préoccupations en matière de vie privée et le besoin de diversifier les ensembles de données.

A. Le Rôle des Données Synthétiques dans l'Amélioration des LLMs

Les données synthétiques peuvent substantiellement compléter le matériel d'entraînement pour les LLMs, en particulier dans des scénarios où les données réelles sont limitées ou sensibles. En générant des ensembles de données réalistes, mais artificiels, les LLMs peuvent être exposés à un plus large éventail de scénarios et de variations linguistiques. Cela élargit leur compréhension et leur réactivité, les rendant plus polyvalents et robustes dans leurs applications.

B. Synergie avec les Annotations avec Intervention Humaine

Bien que les données synthétiques ouvrent de nouvelles voies dans l'entraînement des LLMs, elles ne remplacent pas la compréhension nuancée et les insights contextuels fournis par les annotateurs humains. Les services d'étiquetage de données de SmartOne jouent ici un rôle crucial. Les annotations avec intervention humaine garantissent que les données synthétiques sont alignées sur des contextes réels et des nuances culturelles, comblant le fossé entre les interactions humaines authentiques et artificielles.

C. Apprentissage par Renforcement avec Retours Humaine (RLHF)

L'intégration de données synthétiques avec les retours humains crée un environnement d'entraînement dynamique pour les LLMs. Les annotateurs humains de SmartOne peuvent fournir des retours essentiels, corrigeant et affinant la compréhension du modèle sur la base des données synthétiques. Ce processus itératif améliore la précision du modèle, garantissant que les LLMs sont non seulement riches en données, mais aussi sensibilisés au contexte et alignés éthiquement.

D. Positionnement de SmartOne à l'Ère des Données Synthétiques

Dans le paysage évolutif de l'entraînement des LLMs, SmartOne se positionne comme un partenaire indispensable. En offrant des services d'étiquetage de données experts qui complètent les données synthétiques, SmartOne veille à ce que les LLMs formés avec des données réelles et synthétiques maintiennent un haut niveau de fiabilité, de compréhension contextuelle et de solidité éthique.

IV. Considérations Éthiques dans l’Entraînement des LLMs

La montée des LLMs et leur importance croissante dans diverses applications nécessitent un examen approfondi des implications éthiques associées à leur formation et à leur déploiement. Cela garantit que la technologie s'aligne sur les valeurs sociétales et contribue positivement au progrès humain.

A. Stratégies de Mitigation des Biais

Biais dans les Données d'Entraînement : Une préoccupation éthique majeure dans les LLMs est le potentiel des biais intégrés, issus des données utilisées pour l'entraînement. Ces biais peuvent perpétuer involontairement des inégalités et préjugés sociétaux existants.

Approche Multifacette pour la Mitigation des Biais : Lutter contre les biais nécessite une stratégie compréhensive qui englobe l'évaluation des ensembles de données d'entraînement, le suivi continu des sorties des modèles pour des tendances biaisées, et le développement de techniques visant spécifiquement à rectifier les biais durant la phase d'entraînement.

B. Transparence et Explicabilité

Importance de la Transparence : La transparence est primordiale pour établir la confiance des utilisateurs. Les utilisateurs devraient avoir une compréhension claire et complète de la façon dont les LLMs fonctionnent et arrivent à des décisions spécifiques.

Améliorer l'Explicabilité : Cela implique de concevoir des méthodes qui retracent les décisions du modèle à ses entrées originales, rendant ainsi le processus de prise de décision plus compréhensible et interprétable pour les utilisateurs et les parties prenantes.

C. Vie Privée des Utilisateurs et Sécurité des Données

Équilibre entre la Collecte de Données et la Vie Privée : La collecte et l'utilisation de données pour entraîner les LLMs soulèvent des préoccupations relatives à la vie privée des utilisateurs. Trouver le bon équilibre entre la collecte de données pour améliorer les modèles et protéger la vie privée des utilisateurs est essentiel.

Mise en Œuvre de Mesures Préservant la Vie Privée : Cela peut être réalisé en anonymisant les données, en établissant des contrôles d'accès stricts, et en utilisant des méthodes de cryptage pour sécuriser des informations des utilisateurs et prévenir les accès non autorisés.

D. Évitement des Cas d'Utilisation Nuisibles

Évaluation Proactive des Impacts Sociétaux : L'entraînement des LLMs doit inclure une approche proactive pour identifier et atténuer les cas d'utilisation nuisibles potentiels. Évaluer les impacts et ramifications sociétales possibles des applications des LLMs est crucial.

Développement de Cadres de Collaboration : S'engager avec des éthiciens, des décideurs et la communauté au sens large pour établir des directives et des cadres complets peut prévenir les utilisations malveillantes et les conséquences négatives non intentionnelles.

E. Représentation Inclusive dans les Données d'Entraînement

Importance des Voix Diverses : Assurer la représentation d'une large gamme de voix, de perspectives et de nuances culturelles dans les données d'entraînement est vital. Cela aide à prévenir le renforcement des biais existants et garantit des performances équitables dans divers groupes démographiques.

Amélioration et Mise à Jour Continue : Les LLMs doivent être continuellement mis à jour et améliorés pour s'assurer qu'ils s'adaptent et représentent avec précision les évolutions des paysages sociétaux et culturels.

F. Aborder les Hallucinations dans les Sorties des Modèles

Défi des Hallucinations : Une préoccupation éthique émergente est la tendance des LLMs à « halluciner », ou à générer de fausses informations qui semblent plausibles. Cela peut entraîner la diffusion de données incorrectes, provoquant potentiellement des dommages dans des scénarios où l'exactitude est critique.

Atténuer les Hallucinations : Pour y remédier, il est crucial d'incorporer des méthodologies dans l'entraînement des LLMs qui identifient et réduisent l'occurrence des hallucinations. Cela implique d'affiner les ensembles de données d'entraînement, d'améliorer les architectures des modèles et d'implémenter des contrôles de validation robustes. Un suivi régulier et une mise à jour des modèles pour identifier et corriger ces erreurs sont essentiels.

Conscience des Utilisateurs : Il est également important d'éduquer les utilisateurs sur cet aspect des LLMs, en veillant à ce qu'ils abordent les sorties des modèles avec un œil critique, notamment dans des scénarios critiques.

G. Efforts Collaboratifs pour des Normes Éthiques

Engagement Communautaire : S'attaquer aux considérations éthiques dans l'entraînement des LLMs est un effort collaboratif impliquant des développeurs, des chercheurs, des décideurs et le public au sens large.

Stratégies Complètes : En mettant en œuvre des stratégies de mitigation des biais, des mesures de transparence, des sauvegardes de la vie privée, et en s'attaquant à des défis tels que les hallucinations, le développement et le déploiement des LLMs peuvent s'aligner sur des normes éthiques.

Confiance et Responsabilité : Cela favorise un sentiment de confiance et promeut un usage responsable, assurant que les LLMs sont des outils bénéfiques dans notre paysage technologique en évolution.

X. Apprentissage Continu et Adaptation dans les LLMs

Dans le domaine en évolution rapide de l'IA et des LLMs, l'apprentissage continu et l'adaptation sont essentiels pour maintenir la pertinence et l'efficacité de ces modèles. SmartOne joue un rôle vital dans ce processus continu avec ses services d'étiquetage de données experts. Cette section aborde comment nos approches contribuent à l'apprentissage continu et à l'adaptation des LLMs.

A. Importance de l'Étiquetage de Données de Qualité pour l'Apprentissage Continu

L'apprentissage continu dans les LLMs repose fondamentalement sur la qualité et la pertinence des données d'entraînement qu'ils reçoivent. À mesure que le langage évolue et que de nouvelles données émergent, il est essentiel que les LLMs reçoivent des ensembles de données mis à jour pour apprendre.

Solution : Processus d'Étiquetage de Données Dynamiques

SmartOne propose des services d'étiquetage de données dynamiques qui s'adaptent au paysage linguistique en évolution. Nous veillons à ce que les données d'entraînement pour les LLMs soient non seulement de haute qualité, mais aussi qu'elles reflètent les dernières tendances et modèles d'utilisation. Notre engagement à fournir des données annotées continuellement mises à jour permet aux LLMs de s'adapter et de rester à jour avec les évolutions linguistiques.

B. Étiquetage de Données Axé sur les Retours

Obtenir des insights des applications réelles des LLMs est essentiel pour identifier les domaines où l'étiquetage des données nécessite un raffinement ou une expansion.

Solution : Cadre d'Étiquetage de Données Réactif

Notre cadre d'étiquetage des données est intentionnellement conçu pour être réactif aux retours que nous recevons. Cette agilité nous permet d'ajuster rapidement les stratégies d'étiquetage en fonction des exigences changeantes des LLMs, garantissant que les données d'entraînement restent pertinentes et efficaces.

C. Soutenir l'Adaptation des LLMs aux Variations Contextuelles et Culturelles

Le langage est intrinsèquement divers, variant considérablement à travers différentes cultures et contextes. Pour assurer l'efficacité des LLMs dans de tels cadres variés, l'étiquetage des données doit tenir compte de ces différences linguistiques.

Solution : Annotation de Données Culturellement Diverses

Chez SmartOne, nous employons une équipe d'annotateurs provenant de divers contextes culturels. Cette diversité enrichit notre processus d'étiquetage des données, permettant aux LLMs de s'adapter et de comprendre un vaste éventail de nuances linguistiques et de variations culturelles.

D. Aligner avec les Derniers Développements en IA et LLMs

À mesure que les domaines de l'IA et des LLMs continuent d'évoluer, les exigences en matière d'étiquetage des données et d'exécution de projets évoluent en conséquence. Rester au courant de ces avancées technologiques est essentiel pour fournir un étiquetage de données efficace et des solutions novatrices dans les applications LLM.

Solution : Formation de l'Équipe de Lancement/Projet pour des Solutions Innovantes

Accent sur l'Expertise de l'Équipe de Projet : Chez SmartOne, nous priorisons la formation et le développement continus de notre Équipe de Lancement/Projet, nous assurant qu'ils sont bien informés des dernières tendances et avancées en matière de technologie des LLMs. Cette connaissance est cruciale pour guider l'orientation générale des projets et prendre des décisions éclairées à chaque étape du processus d'étiquetage des données et d'entraînement des LLMs.

Expertise dans Divers Cas d'Utilisation : L'expertise de notre équipe couvre une large gamme de cas d'utilisation des LLMs, nous permettant d'offrir des solutions sur mesure et à la pointe de la technologie à nos clients. Cette expertise est continuellement améliorée par le biais de sessions de formation régulières, d'ateliers et de conférences industrielles.

Défi et Innovation avec les Clients : Grâce à notre compréhension approfondie des capacités et des tendances des LLMs, nous sommes unique à défier nos clients avec de nouvelles idées et conceptions. Nos équipes projet utilisent leurs connaissances pour proposer des approches et des solutions innovantes, repoussant les limites de ce qui est possible avec la technologie des LLMs.

Collaboration et Amélioration Continue : Nous favorisons un environnement de collaboration et d'amélioration continue, où nos équipes projet sont encouragées à partager des connaissances, à apprendre les unes des autres et à rester en avance sur la courbe. Cette approche collaborative garantit que nos clients bénéficient des stratégies LLM les plus avancées et les plus efficaces.

XI. Appliquer les LLMs dans les Applications Industrielles

Les LLMs se sont révélés inestimables dans divers domaines tels que la génération de contenu, la résumé, les interfaces de langage naturel et l'analyse de sentiment. Leur capacité à générer un texte ressemblant à du langage humain dans différents styles et tons a révolutionné la création de contenu. De même, leur expertise dans la résumé de documents longs a considérablement amélioré les processus de recherche d'information. De plus, les interfaces de langage naturel alimentées par les LLMs ont transformé les interactions des utilisateurs avec la technologie. Leur précision dans l'analyse de sentiment a également fourni des insights précieux sur la perception et les opinions publiques (Brown et al., 2020).

Dans le secteur de la santé, les LLMs peuvent aider à diagnostiquer des maladies et à fournir des recommandations de traitement personnalisées en fonction des symptômes et de l'historique médical d'un patient (Esteva et al., 2019). Ils peuvent également améliorer l'efficacité des essais cliniques en analysant d'énormes quantités de données et en identifiant des motifs susceptibles de conduire à de nouvelles percées.

Par exemple, dans le secteur financier, les LLMs peuvent aider les investisseurs à prendre des décisions éclairées en analysant les tendances de marché, les articles d'actualités et les rapports financiers. Ils peuvent également aider à détecter des activités frauduleuses en parcourant de grands volumes de transactions et en signalant des motifs suspects (Arner et al., 2017).

De plus, les LLMs ont des applications prometteuses en service client. Ils peuvent être utilisés pour développer des chatbots fournissant des réponses précises aux requêtes des clients, entraînant ainsi des expériences utilisateur améliorées et une réduction de la charge de travail pour les agents humains.

XII. Intégration des LLMs dans la Réalité Augmentée

La technologie de la réalité augmentée (AR) a le potentiel de révolutionner l'interaction homme-machine en mêlant des éléments virtuels au monde réel. Les LLMs peuvent jouer un rôle significatif pour améliorer cette expérience.

Amélioration de la Recherche d'Information : Avec l'AR, les utilisateurs peuvent accéder à des informations supplémentaires sur leur environnement en temps réel. En intégrant les LLMs dans ce processus, les utilisateurs auront accès à une mine de connaissances à travers des requêtes en langage naturel (Azuma, 1997).

Assistance Virtuelle Améliorée : Combiner l'AR avec les LLMs permet des assistants virtuels plus intuitifs et interactifs. Les utilisateurs peuvent converser naturellement avec ces objets ou personnages rendus numériquement, qui récupéreront instantanément des informations précises à partir d'immenses ensembles de données fournies par les modèles linguistiques.

Compréhension du Langage Contextualisée : Grâce aux techniques de visualisation sophistiquées offertes par l'AR, les LLMs acquièrent une compréhension contextuelle des instructions des utilisateurs dans les dimensions spatiales et temporelles de leur environnement – un facteur qui améliore la précision pendant les interactions.

XIII. Directions Futures de la Recherche dans les LLMs

Le domaine des LLMs évolue rapidement, alimenté par des avancées continues en technologie et en recherche. Cette section explore les tendances futures anticipées et les directions de recherche potentielles qui sont prêtes à façonner le développement des LLMs.

A. Vers une Plus Grande Efficacité du Modèle

Une des tendances significatives dans la recherche sur les LLMs est la poussée vers des modèles plus efficaces. À mesure que les LLMs grandissent en taille et en complexité, les ressources computationnelles nécessaires pour entraîner et exécuter ces modèles augmentent.

Modèles Légers et Innovations Algorithmique

La recherche future devrait se concentrer sur le développement de modèles légers nécessitant moins de puissance computationnelle sans sacrifier les performances. Cela comprend des innovations algorithmiques qui rationalisent les architectures des modèles et les techniques de traitement des données, rendant les LLMs plus accessibles et durables.

B. Capacités Multimodales Améliorées

Les LLMs ont traditionnellement excellé dans le traitement du texte, mais l'avenir réside dans leur capacité à comprendre et à générer du contenu à travers plusieurs modalités, telles que les images, l'audio et la vidéo.

LLMs Multimodaux Avancés

La recherche s'oriente vers la création de LLMs capables d'intégrer harmonieusement des informations provenant de diverses entrées sensorielles, fournissant une compréhension plus holistique de données complexes. Cette avancée ouvrira de nouvelles voies dans les applications d'IA, des assistants virtuels améliorés aux outils de création de contenu sophistiqués.

C. Amélioration de l'Explicabilité et de la Transparence des Modèles

À mesure que les LLMs deviennent plus intégrés dans des secteurs critiques, le besoin d'explicabilité et de transparence des modèles devient primordial.

IA Explicable (XAI)

La recherche future se concentrera probablement sur le développement de méthodes et de cadres pour l’IA explicable (XAI) dans le contexte des LLMs. Cela comprend la création de modèles dont les processus décisionnels sont interprétables et compréhensibles par les humains, assurant confiance et responsabilité dans les systèmes d'IA.

D. IA Éthique, Mitigation des Biais et Confidentialité des Données

Les implications éthiques de l'IA, en particulier en ce qui concerne les biais et l'équité, demeurent un domaine de préoccupation crucial.

Cadres Éthiques et Ensembles de Données Diversifiés

La recherche continuera de se concentrer sur le développement de cadres et de directives éthiques, en particulier en ce qui concerne les biais et l'équité. Cela inclut la création d'ensembles de données d'entraînement plus diversifiés et représentatifs et des techniques pour détecter et atténuer les biais dans les modèles d'IA.

Considérations de Confidentialité des Données

De plus, la recherche future abordera de plus en plus la confidentialité des données dans ces cadres. Garantir que les LLMs sont entraînés sur des données qui respectent le consentement des utilisateurs et les normes de confidentialité sera un axe clé, en parallèle avec la mitigation des biais.

E. Expanding Real-World Applications and Industry Integration

Les LLMs sont prêts à s'intégrer davantage dans divers secteurs, transformant la façon dont les entreprises opèrent et comment les services sont livrés.

LLMs Spécifiques à l'Industrie et Collaboration

Les tendances futures incluent le développement de LLMs spécifiques à l'industrie, adaptés aux besoins uniques de secteurs tels que la santé, les finances, et le juridique. Les collaborations entre chercheurs en IA et experts de l'industrie seront cruciales pour stimuler ces développements.

F. Avancements dans l'Apprentissage Fédéré et Techniques Préservant la Vie Privée

Alors que la confidentialité des données reste une préoccupation majeure, l'apprentissage fédéré et d'autres techniques préservant la vie privée deviendront de plus en plus importants dans l'entraînement des LLMs.

Partage de Données Sécurisé et Modèles d'Apprentissage Décentralisés

La recherche se concentrera sur l'amélioration des algorithmes d'apprentissage fédéré et le développement de nouvelles méthodes pour un partage de données sécurisé et un apprentissage décentralisé. Ces avancées visent à garantir la vie privée des utilisateurs tout en profitant d'un apprentissage collectif.

Incorporation de la Confidentialité dans l'Entraînement des LLMs

Les techniques préservant la vie privée deviendront critiques dans l'entraînement des LLMs, abordant les préoccupations croissantes en matière de confidentialité dans le développement de l'IA.

À mesure que le paysage des LLMs continue d'évoluer avec ces tendances futures et ces directions de recherche, le développement et le perfectionnement continus de ces technologies promettent de débloquer encore plus d'applications et de capacités innovantes.

XIV. Un Futur Brillant pour les LLMs

A. Stratégies de Formation pour Améliorer la Performance des LLMs

Former les LLMs sur des données diversifiées et représentatives qui englobent une grande variété de sujets, de perspectives et de styles linguistiques est crucial pour améliorer leur performance. Cet ensemble de données riche permet aux LLMs de gérer efficacement diverses entrées utilisateur et de mieux comprendre différents types de requêtes ou de demandes (Vaswani et al., 2017). Les techniques d'apprentissage actif peuvent également considérablement améliorer la performance des LLMs. En sélectionnant des exemples non étiquetés à partir de l'ensemble de données en fonction des mesures d'incertitude ou des scores de confiance de prédiction, les formateurs peuvent concentrer les ressources des annotateurs sur des instances difficiles qui entraîneront probablement des gains de performance plus élevés. En outre, l'apprentissage par curriculum, où les formateurs exposent les modèles à des niveaux de complexité croissants pendant la formation, peut également être bénéfique. Cette méthode permet aux LLMs de d'abord comprendre des motifs plus simples avant de passer à des structures linguistiques plus complexes, posant ainsi une base solide pour gérer des tâches difficiles (Bengio et al., 2009).

B. Améliorer la Qualité et la Diversité des Données pour les LLMs

Pour que les LLMs excellent véritablement, leurs données d'entraînement doivent être de la plus haute qualité, englobant la diversité en termes de sujets, de styles linguistiques et de perspectives. Des techniques d'étiquetage de données améliorées sont vitales pour garantir que les informations sont précises, complètes et exemptes de biais. De plus, des méthodologies d'apprentissage actif peuvent être appliquées à l'étiquetage des données, permettant aux annotateurs de se concentrer sélectivement sur des points de données qui sont les plus bénéfiques pour la performance du modèle. Cette approche peut améliorer considérablement la qualité et la diversité de l'ensemble de données d'entraînement. Une évaluation continue et des retours sont également essentiels pour maintenir la qualité de l'ensemble de données et garantir que le modèle fonctionne de manière optimale (Vaswani et al., 2017).

C. Le Rôle de l'Intervention Humaine dans l'Entraînement des LLMs

Incorporer l'expertise humaine dans la boucle d'entraînement est essentiel pour affiner les LLMs et améliorer leurs performances. Les annotateurs humains apportent des insights et des connaissances précieux qui peuvent grandement améliorer la compréhension du modèle du contexte, de la sémantique et des nuances au sein du langage. Cette approche d'intervention humaine dans la boucle garantit que les sorties du modèle sont précises, pertinentes et culturellement appropriées (Brown et al., 2020).

D. Optimisation de l'Efficacité de l'Entraînement et de la Performance des LLMs

Optimiser le processus d'entraînement des LLMs est vital pour atteindre une efficacité et une performance maximales. Les stratégies d'apprentissage actif, telles que l'échantillonnage d'incertitude, la requête par comité, et l'intervention humaine avec apprentissage actif, peuvent considérablement améliorer la courbe d'apprentissage du modèle et améliorer les performances globales. Ces méthodologies priorisent les points de données les plus informatifs et les plus difficiles, permettant au modèle d'apprendre de manière plus efficace et efficiente (Bengio et al., 2009).

Pensées Finales

En naviguant dans le paysage expansif des LLMs, l'interaction complexe entre les données, les méthodologies d'entraînement et les considérations éthiques émerge comme un élément fondamental pour le succès. Les aspects multiples du développement des LLMs, allant de l'étiquetage de données diversifiées et des stratégies d'entraînement aux considérations éthiques d'un déploiement responsable, sont cruciaux pour exploiter tout le potentiel de ces systèmes avancés d'IA.

Dans cette nouvelle ère du traitement du langage naturel, la collaboration entre l'intelligence machine et l'expertise humaine est un incontournable pour le succès. L'importance des données diversifiées et représentatives, soulignée par une évaluation continue et des méthodologies d'intervention humaine, est primordiale. De tels processus guidés par l'humain sont cruciaux pour façonner les LLMs en entités sophistiquées capables de naviguer dans la complexité du langage et des nuances culturelles.

L'exploration des considérations éthiques met en évidence l'importance des pratiques d'étiquetage des données transparentes et d'un engagement à traiter les biais et les préoccupations en matière de vie privée. Cette approche jette les bases d'un écosystème d'IA plus fiable et responsable.

L'adoption de techniques avancées d'étiquetage de données, y compris celles proposées par SmartOne.ai, est instrumentale dans la réalisation du plein potentiel des LLMs. Les véritables services d'intervention humaine de SmartOne.ai, tels que l'annotation, l'étiquetage et le marquage des données, fournissent les insights humains et la curation d'experts nécessaires que les équipes d'IA doivent optimiser leurs modèles d'IA.

En tirant parti de l'expertise et de l'expérience de SmartOne.ai, les organisations peuvent naviguer dans les complexités du développement des LLMs, garantissant que leurs modèles sont robustes, précis et éthiquement sains. Cette collaboration entre l'expertise humaine et l'innovation d'IA n'est pas seulement bénéfique ; elle est essentielle pour l'avancement et le succès continu des LLMs dans le paysage dynamique du traitement du langage naturel et de l'intelligence artificielle d'aujourd'hui.

Contactez-nous

Vous avez du mal à fournir des données de qualité pour l'étiquetage des LLMs à temps et dans le respect du budget ? SmartOne offre la solution. Notre équipe expérimentée, notre processus éprouvé et notre plateforme spécialement conçue aident les entreprises à maximiser la valeur des LLMs tout en minimisant les coûts et les risques.

Que vous commenciez ou accélérez des projets d'apprentissage automatique, nous vous aidons à réaliser pleinement les bénéfices des LLMs de manière efficace. Choisissez les experts mondiaux en étiquetage de données dédiés à la qualité, à la rapidité et à l'affordabilité. Choisissez SmartOne.

Références

Devlin, J., Chang, M. W., Lee, K., & Toutanova, K. (2019). BERT : Pré-formation de transformateurs bidirectionnels profonds pour la compréhension du langage. Dans les Actes de la Conférence 2019 de l'Association des Chapitres Américains des Technologies de Traitement du Langage Humain, 1, 4171–4186.

Brown, T. B., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., Dhariwal, P., … & Amodei, D. (2020). Les modèles linguistiques sont des apprenants en quelques exemplaires. prépublication arXiv arXiv:2005.14165.

Bender, E. M., Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021). Sur les dangers des perroquets stochastiques : Les modèles linguistiques peuvent-ils être trop grands ?. Dans les Actes de la Conférence ACM 2021 sur l'Équité, la Responsabilité et la Transparence, 610-623.

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., … & Polosukhin, I. (2017). L'attention est tout ce dont vous avez besoin. Avancées dans les systèmes de traitement de l'information neuronale, 30.

Hochreiter, S., & Schmidhuber, J. (1997). Mémoire à long court terme. Neural computation, 9(8), 1735-1780.

Wang, Y., Sun, Y., Liu, Z., Sarma, S. E., Bronstein, M. M., & Solomon, J. M. (2019). Dynamic graph CNN pour l'apprentissage sur des nuages de points. ACM Transactions on Graphics (TOG), 38(5), 1-12.

Esteva, A., et al. (2019). Un guide pour l'apprentissage profond dans le secteur de la santé. Nature Medicine, 25(1), 24-29.

Arner, D. W., et al. (2017). FinTech et RegTech en un mot, et l'avenir dans un bac à sable. CFA Institute Research Foundation.

Azuma, R. T. (1997). Un aperçu de la réalité augmentée. Presence: Teleoperators & Virtual Environments, 6(4), 355-385.

Glossaire des Termes

Grands Modèles Linguistiques (LLMs) : Modèles d'IA avancés spécialisés dans le traitement, la compréhension et la génération de langage humain basé sur de grands ensembles de données. Des exemples incluent GPT-3 et BERT.

Étiquetage de Données : Le processus d'identification et de marquage de données brutes (comme le texte ou les images) avec des étiquettes pertinentes pour aider les modèles d'IA à comprendre et à apprendre de ces données.

Annotations : Notes ou étiquettes ajoutées aux données, fournissant contexte, catégorisation ou explications, cruciales pour la formation des modèles d'IA, notamment dans le traitement du langage naturel.

Données Synthétiques : Données générées artificiellement qui imitent des données du monde réel, utilisées pour former des modèles d'IA lorsque les données réelles sont rares, sensibles, ou nécessitent une augmentation.

Intervention Humaine (HITL) : Un modèle de flux de travail où le jugement humain est intégré aux opérations d'IA, garantissant contrôle de qualité et compréhension contextuelle dans les applications d'IA.

Apprentissage Actif : Une approche de formation pour les modèles d'apprentissage automatique où le modèle interroge activement un utilisateur pour étiqueter de nouveaux points de données ayant le plus de valeur informationnelle.

Apprentissage Fédéré : Une technique d'apprentissage automatique où le modèle est formé sur plusieurs appareils ou serveurs décentralisés, améliorant la confidentialité et la sécurité des données.

Mitigation des Biais : Techniques et pratiques visant à réduire les biais dans les modèles d'IA, garantissant équité et intégrité éthique.

Données Multimodales : Données qui se présentent sous diverses formes ou modalités, telles que texte, images, audio, etc., utilisées en IA pour fournir un contexte d'apprentissage plus riche.

Apprentissage par Transfert : Une méthode d'apprentissage automatique où un modèle développé pour une tâche est réutilisé comme point de départ pour un modèle sur une deuxième tâche.

Confidentialité Différentielle : Un système de partage d'informations sur un ensemble de données en décrivant des motifs de groupes au sein de l'ensemble de données tout en cachant des informations sur des individus dans l'ensemble de données.

Traitement du Langage Naturel (NLP) : Une branche de l'IA qui se concentre sur la possibilité pour les ordinateurs de comprendre, d'interpréter et de répondre au langage humain de manière utile.

Apprentissage par Curriculum : Un type d'apprentissage dans lequel les modèles d'IA sont progressivement exposés à des niveaux de difficulté croissants dans les données d'entraînement, améliorant l'efficacité de l'apprentissage.

Explicabilité : Le degré auquel les mécanismes internes d'un système d'apprentissage automatique ou de deep learning peuvent être expliqués en des termes compris par un humain.

Réalité Augmentée (AR) : Une expérience interactive où les environnements réels sont améliorés par des informations perceptuelles générées par ordinateur.

Réseaux de Neurones Graphiques (GNNs) : Un type de réseau neuronal conçu pour capturer les dépendances dans des données structurées en graphe. Ils sont utilisés pour des tâches impliquant des informations relationnelles, comme des réseaux sociaux ou des structures moléculaires.

Architecture Transformer : Une architecture de réseau neuronal basée sur des mécanismes d'auto-attention. Elle a été largement influente dans le NLP pour des tâches comme la traduction, le résumé de texte et la réponse à des questions.

Apprentissage par Renforcement (RL) : Un domaine de l'apprentissage automatique concerné par la manière dont les agents doivent agir dans un environnement pour maximiser la notion de récompense cumulative.

Réseaux Antagonistes Génératifs (GANs) : Une classe de cadres d'apprentissage automatique où deux réseaux neuronaux s'affrontent dans un jeu, utilisés typiquement dans des apprentissages non supervisés et des modèles génératifs.

Apprentissage Non Supervisé : Un type d'apprentissage automatique qui cherche des motifs précédemment non détectés dans un ensemble de données sans étiquettes préexistantes.

Apprentissage Supervisé : Un type d'apprentissage automatique où le modèle se voit fournir des données d'entraînement étiquetées, et le but est d'apprendre un mapping des entrées aux sorties.

Apprentissage Semi-Supervisé : Une classe de techniques qui utilise à la fois des données étiquetées et non étiquetées pour l'entraînement. Ces méthodes peuvent améliorer significativement la précision de l'apprentissage avec des données étiquetées limitées.

Affinage : Un processus consistant à apporter de petits ajustements à un modèle pré-entraîné pour l'adapter à une tâche ou à un ensemble de données spécifiques, souvent utilisé dans des scénarios d'apprentissage par transfert.

Ajustement des Hyperparamètres : Le processus de sélection du meilleur ensemble de paramètres pour un algorithme d'apprentissage, souvent crucial pour améliorer la performance des modèles d'apprentissage automatique.

Compréhension du Langage Naturel (NLU) : Un sous-domaine de la NLP axé sur la compréhension de la lecture par les machines, concerné par la capacité d'un programme à comprendre le langage humain sous forme de phrases ou de contextes conversationnels.

Interprétabilité du Modèle : Le degré auquel un humain peut comprendre la cause d'une décision prise par un modèle d'apprentissage automatique. C'est crucial pour diagnostiquer le comportement du modèle et assurer l'équité et la transparence.

Apprentissage Automatique Préservant la Vie Privée : Techniques en apprentissage automatique qui protègent la vie privée des données des individus tout en permettant aux modèles d'apprendre à partir de ces données. Les méthodes incluent la confidentialité différentielle, l'apprentissage fédéré et le chiffrement homomorphe.

Descente de Gradient Stochastique (SGD) : Une méthode d'optimisation largement utilisée en apprentissage automatique et en deep learning pour former des modèles, particulièrement efficace pour de grands ensembles de données.

Mécanismes d'Attention : Composantes des réseaux neuronaux qui pèsent différemment la pertinence des différentes parties d'input, améliorant l'attention du modèle sur des éléments importants. Ils sont clés dans les modèles Transformer.

Tokenisation : Le processus de conversion d'un texte en unités plus petites (tokens), typiquement des mots ou des sous-mots, qui peuvent être par la suite traitées ou comprises par des algorithmes.

Articles récents

Sommet de l'IA générative 2024

Sommet de l'IA générative 2024

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : contrôle logistique IA

Étude de cas client : contrôle logistique IA

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Classification des produits

Étude de cas client : Classification des produits

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Essayage virtuel de vêtements

Étude de cas client : Essayage virtuel de vêtements

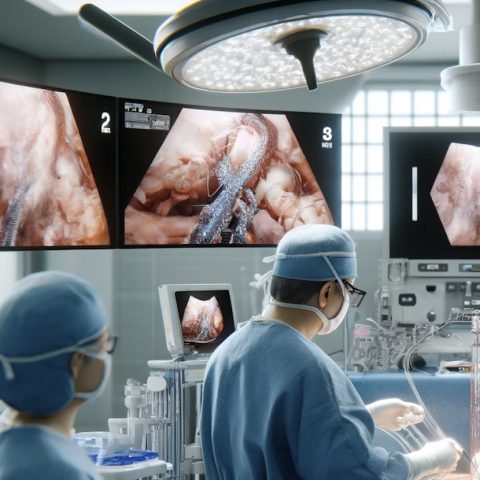

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données