Le rôle des données d'entraînement dans les modèles IA de traitement du langage naturel (NLP)

5 mai 2024

Le langage de conversation quotidien, connu sous le nom de langage naturel, présente une multitude d'opportunités pour les technologies IA. Si nous pouvons enseigner aux machines à comprendre nos principes et nuances de langage de base, cela améliorera considérablement le potentiel des outils technologiques tels que les chatbots.

Depuis plusieurs années, les chatbots sont un sujet brûlant dans le monde de la technologie, grâce aux avancées de la technologie de traitement du langage naturel (NLP). Mais qu'est-ce que la NLP exactement et comment fonctionne-t-elle ? Ce guide complet vise à fournir une compréhension plus approfondie de cette technologie innovante et du rôle crucial des données d'entraînement pour sa mise en œuvre réussie.

Déchiffrer le traitement du langage naturel

Le langage naturel représente la communication verbale que nous utilisons dans nos interactions quotidiennes. Jusqu'à récemment, comprendre ce langage était un défi pour les machines. Cependant, les chercheurs en IA développent désormais des technologies capables de comprendre le langage naturel, ouvrant ainsi la voie à un potentiel immense et à des percées futures.

Il y a trois étapes fondamentales dans le traitement du langage naturel :

Déchiffrer l'entrée de l'utilisateur et interpréter sa signification à l'aide d'algorithmes spécifiques.

Décider de la réponse appropriée à l'entrée de l'utilisateur.

Générer une réponse compréhensible pour l'utilisateur.

De plus, la technologie NLP effectue trois actions principales : compréhension, prise de décision et réponse.

Compréhension : La machine doit d'abord comprendre l'entrée de l'utilisateur. Cette étape utilise la compréhension du langage naturel (NLU), un sous-domaine de la NLP.

Prise de décision : La machine doit décider comment réagir à l'entrée de l'utilisateur. Par exemple, si vous demandez à Alexa de commander du papier toilette sur Amazon, Alexa comprendra et exécutera votre demande.

Réponse : Enfin, la machine doit répondre à l'entrée de l'utilisateur. Après qu'Alexa ait réussi à passer votre commande, elle devrait vous informer : "J'ai commandé du papier toilette, et il devrait arriver demain."

Malgré les avancées, de nombreuses applications NLP, comme les chatbots, ont encore du mal à correspondre aux capacités conversationnelles humaines et répondent souvent avec un ensemble limité de phrases.

L'analyse de sentiment, une méthode d'identification et de catégorisation des opinions dans un texte pour comprendre l'attitude de l'auteur, est une partie cruciale de la NLP, en particulier lors de la création de chatbots. Ce processus impacte la phase de "réponse" de la NLP. Le même texte d'entrée pourrait nécessiter des réponses différentes de la part du chatbot selon le sentiment de l'utilisateur, qui doit être annoté pour que l'algorithme puisse apprendre.

Pour améliorer les capacités de prise de décision des modèles IA, les data scientists doivent leur fournir d'énormes quantités de données d'entraînement. Cela permet aux modèles d'identifier des modèles et de faire des prédictions précises. Cependant, les données brutes, telles que les enregistrements audio ou les messages texte, ne suffisent pas pour entraîner des modèles d'apprentissage automatique. Les données doivent d'abord être étiquetées et organisées dans un ensemble de données d'entraînement NLP.

Rôle de l'annotation des données dans le traitement du langage naturel

L'annotation d'entités consiste à étiqueter des phrases non structurées avec des informations pertinentes, permettant ainsi la compréhension par la machine. Par exemple, cela pourrait impliquer de marquer toutes les personnes, organisations et lieux dans un document. Dans la phrase "Mon nom est Andrew", Andrew doit être étiqueté avec précision comme un nom de personne pour que l'algorithme NLP fonctionne correctement.

L'annotation du texte linguistique est également cruciale pour la NLP. Parfois, les membres de la communauté IA sont invités à annoter quels mots sont des noms, des verbes, des adverbes, etc. Ces tâches peuvent rapidement devenir complexes, car tout le monde ne possède pas les connaissances nécessaires pour distinguer les différentes parties du discours.

Le traitement du langage naturel varie-t-il selon les langues ?

En anglais, il y a des espaces entre les mots. Cependant, ce n'est pas le cas dans certaines langues, comme le japonais. Bien que la technologie requise pour l'analyse audio reste cohérente à travers les langues, l'analyse de texte dans des langues comme le japonais nécessite une étape supplémentaire : séparer chaque phrase en mots avant que les mots individuels puissent être annotés.

Compréhension améliorée grâce aux technologies NLP

Au cœur de ces technologies se trouve la capacité d'analyser et de traiter d'énormes volumes de données linguistiques. En employant des algorithmes d'apprentissage profond, les systèmes NLP peuvent reconnaître des modèles et apprendre d'eux, améliorant progressivement leur précision dans la compréhension de l'intention de l'utilisateur. Cette technologie ne comprend pas seulement le sens littéral des mots, mais apprécie également les subtilités du contexte, du ton et de l'émotion, qui sont cruciaux pour une communication efficace.

De plus, les avancées dans la compréhension sémantique permettent aux systèmes NLP d'effectuer des tâches nécessitant une compréhension plus profonde du langage humain. Des exemples incluent le résumé de documents longs, la génération de contenu et même la traduction de langues avec un haut degré de précision. Cette compréhension améliorée est essentielle pour développer des applications IA qui sont plus accessibles, utiles et intégrées de manière transparente dans les flux de travail humains.

Annotation des données : approfondir la compréhension du langage par l'IA

L'annotation des données est le processus laborieux mais crucial qui se déroule en coulisses de chaque application NLP efficace. Cette tâche méticuleuse consiste à étiqueter les données textuelles avec des métadonnées qui décrivent leur structure linguistique, leur intention et leur signification sémantique.

Les annotateurs jouent un rôle clé car ils identifient et marquent divers éléments du texte, tels que des entités (par exemple, personnes, lieux et organisations) et des relations entre ces entités. Ils catégorisent également les parties du discours, annotent les dépendances syntaxiques et étiquettent des caractéristiques pragmatiques telles que le ton et le style. Chacune de ces annotations aide l'IA à "comprendre" le texte d'une manière qui s'aligne de plus près avec la compréhension humaine.

En outre, les services d'analyse de sentiment constituent un aspect sophistiqué de l'annotation des données qui consiste à détecter le sentiment véhiculé dans un texte, qu'il soit positif, négatif ou neutre. Cette capacité est cruciale pour des applications telles que les chatbots de service à la clientèle, qui doivent répondre de manière appropriée au ton émotionnel des requêtes ou des plaintes des clients. La précision et la profondeur de l'annotation des données influencent directement l'efficacité avec laquelle les technologies NLP peuvent engager et maintenir des interactions significatives avec les utilisateurs.

L'ensemble du processus de traitement du langage naturel implique le développement d'opérations et d'outils appropriés, la collecte de données brutes pour annotation, et l'engagement à la fois des chefs de projet et des travailleurs pour annoter les données.

Pour l'apprentissage automatique, le volume de données d'entraînement est la clé du succès. Il convient également de noter que, bien que l'anglais soit la langue principale pour de nombreuses grandes entreprises menant des recherches en IA, telles qu'Amazon, Apple et Facebook, le facteur le plus crucial reste le volume de données d'entraînement disponibles. Le volume de données d'entraînement est également critique pour d'autres domaines de l'IA, tels que la vision par ordinateur et la catégorisation de contenu. De plus, la qualité des données est un goulot d'étranglement significatif pour l'avancement technologique.

Donc, si vous et votre équipe avez besoin d'aide pour des services d'annotation de données textuelles/NLP, n'hésitez pas à nous contacter !

Articles récents

Sommet de l'IA générative 2024

Sommet de l'IA générative 2024

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : Comptabilité automatisée pour un traitement intelligent

Étude de cas client : contrôle logistique IA

Étude de cas client : contrôle logistique IA

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Filtre de requête pour une plateforme CRM

Étude de cas client : Classification des produits

Étude de cas client : Classification des produits

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Interius Farms révolutionne l'agriculture verticale avec l'IA et la robotique

Étude de cas client : Essayage virtuel de vêtements

Étude de cas client : Essayage virtuel de vêtements

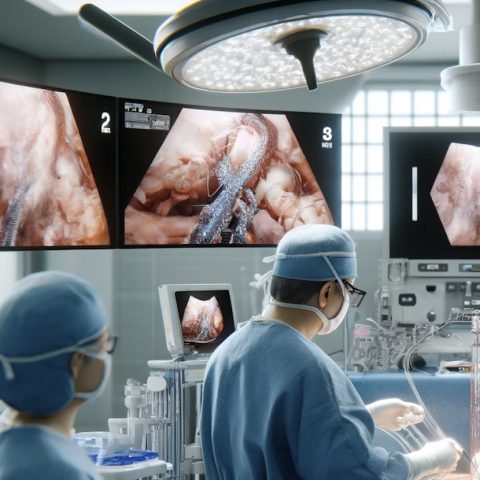

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : SURGAR proposant une réalité augmentée pour la chirurgie laparoscopique

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Gestion intelligente des drones

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données

Étude de cas client : Correspondance des éléments de requête pour la gestion de base de données